Category Archives: Gestensteuerung

©Felix Faire

Mit CONTACT wird jede feste Oberfläche zu einem Interface. Es handelt sich um ein akustisches Forschungsprojekt, das jede harte Oberfläche zu einem Interface werden lässt. Es gehört als laufendes Forschungsprojekt zum Interactive Architecture Lab – Bartlett School of Architecture und wird durch Ruairi Glynn supervised. Er wurde bereits vor Monaten in diesem Blog vorgestellt. Fearful Symmetry in der Tate Modern, London von Ruairi Glynn.

©Felix Faire

CONTACT verwendet Kontakt Microphone. Passive Sonar und waveform werden analysiert um Berührungsinformationen zu erkennen. Zum Beispiel wenn eine Oberfläche berührt wird oder aber wie eine Hand mit der Oberfläche in Kontakt kommt. Vielleicht mit den Fingernägeln, den Fingerkuppen, der Handfläche oder dem Gelenk. Das empfangene Geräusch auf der Oberfläche wird durch die Kontaktmikros digitalisiert „resonated“ und ein melodischer Ton wird davon ableitet.

Piezo Sensoren und Arduino werden zur Lokalisierung von Lautstärken Signalen verwendet. Die Unterschiede der Lautstärken werden verglichen und mit X&Y gemapped. Die Microphone werden mit einem Audio Interface verbunden und in Ableton Live und Max/MSP werden detaillierte Frequenzinformationen der Oberflächenvibration abgebildet. Schlussendlich vergleicht der MAX Patch die Signale, relative Entfernung und schickt die Informationen mittels OSC an Processing. Dann findet ein Abgleich mit der Oberfläche statt.

©Felix Faire

Felix Faire ist ein Designer, Musiker und Creative Coder. Er studierte an der Cambridge University und behandelte in seiner Abschlussarbeit spatial music perception. Momentan ist er im Masterprogramm der MSc Adaptive Architecture and Computation Klasse, eine thematische Ausrichtung am Interactive Architecture Lab.

©Felix Faire

Ich danke CreativeApplications.Net .

Beitrag von Ursula Drees

©Daniel Rozin_DEZEEN_Weave Mirror

Mechanical Mirrors von Daniel Rozin: Mit Alltagsobjekten stellt er Spiegelbilder her. Daniel Rozin ist kein Newcomer. In seinen interaktiven Installationen werden Motoren und Senoren verwendet um Objekte zu spiegelartigen Flächen zu machen. Wer sich vor diese Installationen stellt, wird entsprechend abgebildet. Alle möglichen Gegenstände werden gesammelt, zusammengefügt und mechanisch betrieben. Kleine Plastikstreifen, alte DVD’s, Holzstöpsel, -Stifte oder Zapfen. Rozin fügt sie zu Bildern zusammen, mit und ohne Rahmen. Hinter jedem Objekt oder Bild befinden sich versteckte Kameras die real time die gesehenen Daten an einen Rechner vermitteln, der konvertiert das Signal-Bild in einen 830 byte Video Signal. Selbstgeschriebenen Software schickt an jeden Motor entsprechende Signale und die kleinen Module richten sich aus. Das Resultat ist ein Spiegelbild einer Person oder eines Objekts.

©Daniel Rozin_DEZEEN_Peg Mirror

„The mechanical mirrors are made of various materials but share the same behaviour and interaction,“ so Rozin. „Any person standing in front of one of these pieces is instantly reflected on its surface.“

Ich habe schon das ein oder andere Spiegelbildwerk gesehen und live erzeugt. Die kleinen Motoren arbeiten, summen und knacken, bis die richtige Position erreicht ist. Dann entsteht das Bild, entweder rudimentär, wie in alten Pixelzeiten oder abstrahiert. Spannend wie die Motoren entsprechende Reflexionswinkel einnehmen um Hell- Dunkel produzieren. Es ist belebt.

Seine aktuelle Arbeit, „Angles Mirror“ besteht aus 465 Plastikspeichen in einem Dreieck.

©Daniel Rozin_DEZEEN_Angles Mirror

Beitrag von Ursula Drees

©TOR DAL

Der Israelische Designer Tor Dal hat eine Reihe von Gadgets gemacht, die mit Hilfe der social networks die nahe Zukunft voraussagen. Und dieses Wissen wird dann entsprechend in den persönlichen Tagesplan und -Ablauf eingebunden. Zu den Gedgets gehört witzigerweise das persönliche Horoskop, aber auch Wahrscheinlichkeitsberechnungen für den Besuchs des Fitnessstudios, Freundbesuche oder Einkaufen zu gehen. Oder sogar zur Stimmung der Partners bei der Rückkehr nach dem Arbeitstag. Das Konzept arbeitet zweigleisig. Es beginnt mit dem Downloaden einer App auf das Smartphone. Diese App durchforstet soziale Netzwerke nach Informationen, die den Betreiber in irgendeiner Art und Weise betreffen könnten. Ein Algorithmus ermittelt Regelmässigkeiten oder Verhaltensmuster und leitet die Vorhersage ab. Je mehr der Betreiber hinzufügt desto intelligenter kann die Applikation arbeiten. Dazu gehören natürlich auch Kalender, Kreditkarteninfos, Google, Apple, Facebook und was sonst noch so drin steckt.

„When it identifies a predictable action, a recommended response for solving the problem or enhancing the experience is calculated and presented,“ erklärt Dor Tal.

Der zweite Teil des Projekts wurde Pedictables (Vorhersagen) genannt. Zwei Devices, Geräte die die Daten dem Benutzer präsentieren. Das erste Gerät ist ein Pico Projector. Auf einem graphischen Zeitstrahl werden eine Anzahl von runden Aktivitätenkreise abbildet. Die Farben geben Auskunft über die zeitliche Einordnung. Passiert etwas sehr bald oder darf noch ein bisschen Zeit verstreichen. Rot bedeutet Aktion, Grün: easy going.

©TOR DAL

Wenn der Benutzer sich aus dem Haus begibt kann eine Handprojektion mit der Smartwatch diese Funktionen abbilden. Mit Gestensteuerung wird das Display kontrolliert.

„One interesting aspect of the interaction, similar to what happens in the Back to the Future films, is that the predictions continuously change as the user acts and reacts in present time,“ so Tal.

©TOR DAL

Das Projekt war Teil des Graduation Programms der Bezalel Academy of Arts and Design in Jerusalem. Es lief unter dem Titel FUTUR CONTROL. „From the movement of the stars to modern technology, man has searched for patterns that can indicate the imminent future,“ so Tal. „The biggest challenge of this project is to create the forecasting algorithms, but I believe this will happen sooner than expected.“

Beitrag von Ursula Drees

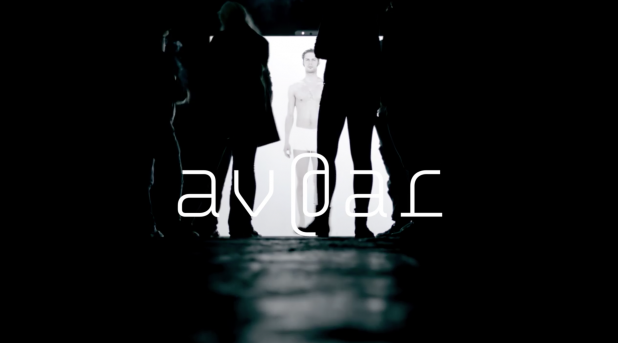

©av@ar von Manfred Borsch, interaktive Installation mit Gestenerkennung

Wir stellen die Diplomarbeit von Manfred Borsch, videograph, mit dem Titel „av@ar“ vor. Sie entstand am Institut Für Musik Und Medien. Herr Borsch hat nach der ersten Sicht freundlicherweise in einem online Interview Hintergrundfragen beantwortet. Mit diesem Wissen steigt der Genuss am Werk. es ist poetisch und hintergründig. Hintergründig weil die Interaktion sowohl aktiv als auch inhaltlich erarbeitet wird. Wer nicht genau hinschaut kann die Tiefe des Werks übersehen. Und das wäre schade.

UD: „Wie wird die Gestenerkennung gemacht? Haben sie Kinects eingesetzt? Wird Mimik abgenommen? Wenn ja, wie haben sie das technisch gelöst?“

MB: Die Gestenerkennung ist wie von Ihnen richtig vermutet mit einer Kinect, OpenNI mit NITE Middleware und der Programmierungsumgebung Max/MSP/Jiitter realisiert worden. Die Mimik wird nicht durch die Kamera aufgenommen, trägt jedoch thematisch zum geschlossenen Kreislauf der Installation bei.

Als Avatar wurde ein Mensch (und eben nicht eine digitale Form, wie beispielsweise eine Pixelansammlungen) gewählt, da durch Spiegelneuronen die Bindung zwischen BesucherIn und Abbild erhöht wird. Hierzu zählt auch das (teils unbewusste) Nachahmen von Emotionen mit der Gesichtsmuskulatur. Da alle Auswirkungen des Handelns in der Installation erforscht werden sollen, es also keine Spielanleitung o.ä. gibt, ist den InterakteurInnen zu Beginn nicht bekannt, ob sie auch mit ihrer Mimik einen Einfluss auf das Geschehen haben.

Diese Abhängigkeiten können im geschlossenen Kreislauf erkundet werden, was sich auf die Wechselseitigkeit von Körper (Interface) und Emotionen (audiovisuelle Reaktionen) gründet.

Bekannt ist die Richtung, dass Emotionen erlebt werden und sich daraufhin das Körperliche verändert, beispielsweise in der Gesichtsmuskulatur, die sich zu einem Lachen hin verzieht. Dies beschreibt beispielsweise Paul Ekman mit dem Facial Action Coding System. Andersherum zeigt die Kognitionswissenschaft im Forschungszweig Embodiment, dass Gefühle auch nach der körperlichen Regung erzeugt werden können. Ein bekanntest Beispiel hierzu ist der quer in den Mund genommene Bleistift, der zur Anspannung von Muskeln im Gesicht führt, die eigentlich zum Lächeln benutzt werden. Forschungen haben ergeben, dass ein solcher, emotional unbewusster, äußerer Einfluss zu deutlich positiveren Bewertungen von Situationen führt, als bei der neutralen Vergleichsgruppe.

©av@ar von Manfred Borsch, interaktive Installation mit Gestenerkennung

Generell steht in der Installation die Frage der Kontrolle, der Auswirkung, im Mittelpunkt. Was kann ich direkt kontrollieren? Wo erlebe ich Kontrollverlust? (zufällige Fehler zur Kontrollminderung sind vorhanden.) Und in wieweit werde ich kontrolliert/geleitet, also wonach richte ich mein Handeln aus. Diese durch die Überlagerung der Rezeptions- und Handlungsebene sehr individuelle Erfahrung kann zur Reflexion über eigene Handlungsziele führen. Beispielsweise kann ich erlernte Körperhaltungen wiederholen, um dem umherstehenden Publikum zu zeigen, dass ich Kontrolle ausübe, ich kann mich auf die Suche nach neuen Bildern und Tönen machen, ich kann die Synchronität der Bilder und der Musik in den Mittelpunkt stellen (VJing) oder mich zu der Musik bewegen, die ich durch meine Bewegung selber schaffe.

UD: Wie viele Reaktionen des medialen Ichs wurden vorproduziert?

MB: Es gibt 16 Einzelemotionen, die in vier Gruppen, den sogenannten Basisemotionen unterteilt sind. Mehr dazu unten… 🙂

Mit dem Überbegriff der Basisemotion versehen, werden die Emotionen wie folgt gruppiert:

Angst, Neid, Scham, Trauer: negative Emotion, passives Verhalten

Freude, Bewunderung, Stolz, Glück: positive Emotion, aktives Verhalten

Liebe, Mitleid, Dankbarkeit, Hoffnung: positive Emotion, passives Verhalten

Hass, Verachtung, Ärger, Verzweiflung: negative Emotion, aktives Verhalten.

©av@ar von Manfred Borsch, interaktive Installation mit Gestenerkennung

UD: Gibt es eine Relation zwischen den Einstellungsgrössen und den Besucheraktivitäten. Wann wird eine Detail oder Gross Einstellung genommen wann Halbtotale oder Totale?

MB: Es gibt eine mögliche Raum- und eine Körpererfahrung.

Der Raum kann in seiner Tiefe (Abstand der AkteurInnen zur Leinwand) erforscht werden, worauf sich die mediale Reflexion nach der Proxemik (E.T. Hall) in vier Stufen anpasst. Dies ist eingeteilt in die öffentliche Distanz (> 3m), gesellschaftlich-wirtschaftliche Distanz (1,5-3m), persönliche Distanz (0,5-1,5m) und die intime Distanz (< 0,5m) und wird so auch visuell Abgebildet (tief im Raum, als Spiegelsituation, Portraitdarstellung und Detailaufnahme. Je kleiner der Abstand, desto dezenter die dargestellte Emotion). Der Raum kann auch im Volumen erfahren werden, ausschlaggebend hierfür ist die durchschnittliche Höhe beider Hände. Hier können die vier Basisemotionen angesprochen werden. (Bsp.: Befinden sich beide Hände über der Kopfhöhe, wird die Basisemotion Angst angesprochen. Befindet sich der Akteur sehr nah vor der Leinwand, erscheint die Detailaufnahme – intime Distanz – des sich aufreißenden Auges). So ist der Raum mit vier Basisemtionen komplett abgedeckt.

Darüber hinaus können die weiteren 12 (Sekundär-)Emotionen durch bestimmte Körperhaltungen angetriggert werden. Hierbei muss erforscht werden, welche Körperhaltung zu welcher audiovisuellen Reaktion führt. (Bsp.: Beide Hände auf die Hüften gestützt, Oberkörper aufrecht -> Emotion Stolz). Auch diese Sekundäremotionen sind auf den vier verschiedenen Distanzebenen darstellbar, sodass es insgesamt (16×4) 64 vorproduzierte visuelle Reaktionen gibt.

©av@ar von Manfred Borsch, interaktive Installation mit Gestenerkennung

UD: Reagiert die Musik auch?

MB: Die Musik reagiert ebenso auf das Handeln der AkteurInnen, entzieht sich jedoch zum Teil durch Statistiken. Die Komposition unterteilt sich in vier Ebenen, die stets zusammen erklingen, und sich auf die vier deutschen Begriffe zur Emotion gründen. (Affekt, Gefühl, Emotion und Stimmung: je kürzer die Emotion, desto Objektbezogener. Ein Affekt (sehr kurz) ist somit sehr objektbezogen.) Die oberste musikalische Ebene (Affekt-Ebene) ist direkt an das Bild gekoppelt und kann zu jedem Zeitpunkt angespielt werden. Sie verton sehr genau alle 64 dargestellten Bilder. Die darunter liegende Gefühlsebene ist doppelt so lang (zwei Takte), berechnet sich aus dem Durchschnitt der zuvor angetriggerten Affekten und stellt die 16 Emotionen dar. Ebene drei (Emotionsebene) ist wiederum länger (vier Takte), wird aus dem Durchschnitt der angespielten Affekten berechnet und vertont die vier Emotionsgruppen (s.o.). Die längste Ebene (Stimmungsebene) unterscheidet nur noch zwischen positiv-annähernd und negativ-ablehnend (der emotionalen Grundtendenzen Neugeborener nach) und ergibt sich aus den Handlungen der letzten acht Takten (ca. 26 Sekunden).

Die musikalische Komposition (Tonart, Rhythmus, Melodie,..) bezieht sich hierbei auf die Affektenlehre des Barock, ein Regelwerk, dass sehr klare Vorgaben zur Vertonung von Emotionen vorsah, sich also sehr gut in den Grundcharakter der Installation einfügt, in der etwas sehr Menschliches wie Emotionen radikal in Gruppen einsortiert, systematisiert und damit abrufbar gemacht wird.

Ich bedanke mich für die inhaltsvollen und Erkenntnis unterstützenden Antworten!

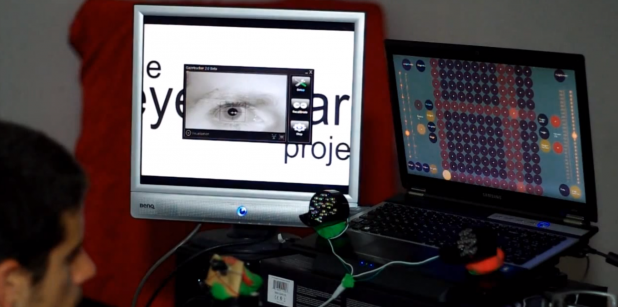

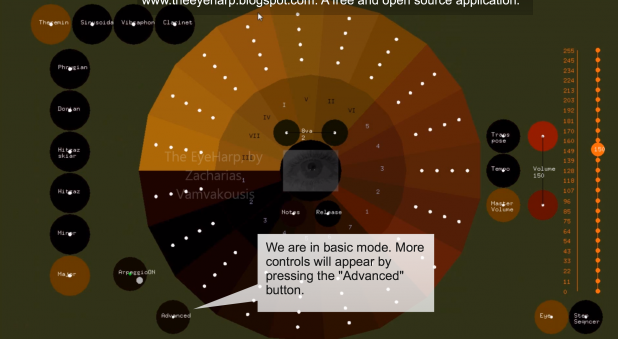

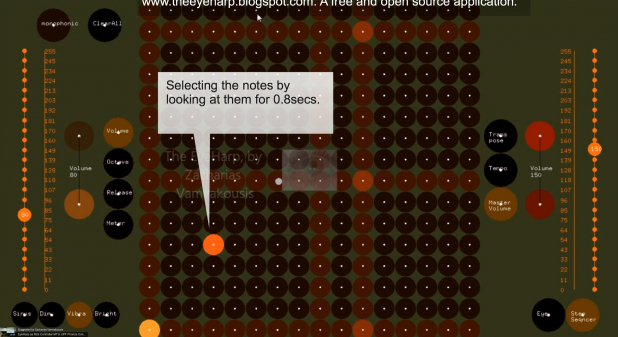

© EyeHarp_ a new Interface for Musical Expression_2012_ Zacharias Vamvakousis

Die Bewegung der Iris wird abgenommen und auf eine Musiklibrary übertragen. Mit anderen Worten, die Bewegung der Iris komponiert Musik. Der Video zeigt die Besucher auf der NIME 2012 Konferenz in Detroit. Für die Programmierung wurde ITU Gazetracker Open Source Eye Tracking Software verwendet. Zacharias Vamvakousis, Athens, Greece, PhD Kandidat am MTG, UPF, Barcelona hat diese Software getriebene Musiksteuerung entwickelt. Supervisor: Dr. Rafael Ramirez.

Mehr unter http://www.youtube.com/watch?v=d8OanafChKs

© EyeHarp_ a new Interface for Musical Expression_2012_ Zacharias Vamvakousis

© EyeHarp_ a new Interface for Musical Expression_2012_ Zacharias Vamvakousis

Das Eyeharp Projekt will Menschen mit Lähmungen durch Amyotrophic Lateral Sclerosis eine Steuerung für Musik ermöglichen. Das Instrument kann alternativ auch durch jeden anderen Controller oder Device beitreiben werden. Am einfachsten durch eine Maus. Es kann ein Musikinstrument für Menschen mit unterschiedlichen Behinderungen sein. Eyeharp wird in openframeworks v0.6 implementiert.

© EyeHarp_ a new Interface for Musical Expression_2012_ Zacharias Vamvakousis

© EyeHarp_ a new Interface for Musical Expression_2012_ Zacharias Vamvakousis

Beitrag von Ursula Drees