Tag Archives: Augmented Media

Foto: FMX 2018©Katja Schmid

Menschen träumen schon immer davon, die Welt nach ihren Vorstellungen zu gestalten. Nun scheint es so, dass heutige Filmemacher dieser göttlichen Vision näher denn je kommen. Virtual Production, VR, Realtime Technologien, Dronen, LED Displays, fotorealistische Simualtions- und Render Algorithmen, Motion Capture, Facial Capture, Photogrammetrie und Machine Learning gestatten den Kreativen, sich eine glaubhaft, zum Verwechseln echte Welt zu schaffen, in der Charaktere (Menschen oder synthetische Figuren) agieren.

Foto: FMX 2018,Dominique Brewing and Luzie Marquardt

Habib Zargarpour (CCO und Co-Founder von Digital Monarch Media) bringt es nach einem langen Tag zu Virtual Production auf den Punkt: „Es geht um einen Paradigmenshift. Die Filme werden anders werden“.

Er hatte zuvor das Virtual Film Tool Expozure life vorgestellt, mit dem in einer virtuellen Umgebung die Previsualisierung in realtime aufgenommen, also der Film visuell konzipiert werden kann. Mittels eines handheld devices kann der Kameramann oder Regisseur in der virtuellen Welt Einstellungen wie am Set gestalten. Am Ende des „Drehtages“ werden die Shots zu einer Szene zusammengeschnitten. Expozure kam für den Science-Fiction Film Blade Runner 2049 (executive producer Ridley Scott, Regie: Denis Villeneuve) zum Einsatz. „Was wäre, wenn wir in Zukunft unsere Geschichten direkt aus den Welten, die wir gebaut haben, entwickeln würden – also zu einem life perform of storybuilding übergingen?“ Wie würden sich die Filme verändern, wenn statt auf der Basis von Text, die zukünftigen Geschichten in der menschengemachten, visuellen Welt entstünden?

An Blade Runner 2049 hat auch Axel Akesson (MPC) mitgewirkt. Als Asset Supervisor war er für die digitale Replikation von Rachael verantwortlich.

Die größte Herausforderung beim Erstellen von Digital Humans ist die Überbrückung des uncanny valley (es bezeichnet die beim Zuschauer entstehende innere Akzeptanzlücke von künstlich hergestellten Personen. Der Realitätsgehalt eines virtuellen Characters kann entgegen der Erwartung von größtmöglicher Realitätsnähe zu einer minderen Akzeptanz beim Rezipienten führen, wenn dieser Differenzen zum antizipierten Original als störend wahrnimmt.) „Tote Augen“ sind die größten Illusionsbrecher und eine Herausforderung. Axel Akesson spricht in dem folgenden Interview über die neuen Methoden der Lichtberechnung im Augapfel, aus welchen Komponenten die digitale Rachael besteht, über die Vorteile, die Virtual Production mit sich bringt, was zukünftig noch an Verbesserungen zu erwarten ist und warum echte Filmfotografie für ihn immer noch das non plus ultra ist.

Ian Comley, CG Tech Supervisor, ILM vertritt folgende Perspektive zu Virtual Production: “It is not a substitute for good storytelling. It’s a tool, it’s not a replacement.” Die Tools haben sich konstant in vielen Gebieten weiterentwickelt und sich gegenseitig beeinflusst. Besonders was look development angeht, werden solide Referenzen, mit denen dann Prototypen entwickelt werden, bevorzugt. Sie helfen um schlussendlich zu einer hohen Glaubwürdigkeit zu gelangen. Ian kann sich zwei Zukunfts-Szenarien vorstellen. Einerseits können die Entwicklungen ohne jeden Anteil an realer Filmfotografie zu digitalen Welten und digitalen Charakteren im Film führen. Andererseits sollten perfekte Drehorte weiterhin verwendet werden,, wenn es sie gibt, denn sie verfügen nicht minder über Realitätsanspruch. Was digitale Schauspieler angeht, beantwortet er die Frage: „Can you fully synthesize a human performance through artificial intelligence?“ eindeutig mit „Ja“. Nach Ian Comley sind künstliche Charaktere genauso überzeugend und in der Lage Zuschauer in ihre Geschichte zu involvieren, wie menschliche Schauspieler.

“Creating worlds – that is what we all love to do. It is the escapism that a lot of us love. It’s the endless possibility of making a whole new universe and its own rules.” meint Shannon Justison (Visualization Supervisor, The Third Floor). Im Prozess der Previsualisierung nehmen die ersten Ideen reale Formen an, lang bevor der eigentliche Dreh stattfindet. Über die Zukunft des storytellings denkt sie oft nach: „The truth is: I don’t know. And that is the interesting part. I can imagine all these opportunities for virtual reality storytelling, augmented reality storytelling are bouncing in my head. And honestly, I don’t have a coherent thesis on that. But I am just really excited to see where it goes.”

“Tools for the next generation of storytelling” ist der Titel für Daniel Gregoire’s Vortrag auf der FMX. Er ist der Gründer der Firma Halon Entertainment, und wirkte an einer Vielzahl von Blockbustern als Previs Supervisor mit (War of the Worlds, Kung Fu Panda, Spider-Man 3, Life of Pi, Birdman or (The Unexpected Virtue of Ignorance), Jurassic World, The Hunger Games, Dawn of the Planet of the Apes, Alice Through the Looking Glass, Star Wars: The Force Awakens, Deepwater Horizon, Logan, and Kong: Skull Island). Sein Fokus liegt auf der Durchdringung von neuen Technologien und Storytelling und dafür nennt er ein eindrückliches Beispiel: „Photogrammetry hat es uns ermöglicht, den Ort, den wir beim location scouting besichtigt haben, buchstäblich mit nach Hause zu nehmen.“ Davon profitiert das gesamte Team, wenn es dann mit Hilfe der digitalen Kopie kreative Entscheidungen treffen kann.

Daniel macht in seinem Gespräch mit uns deutlich, wie schnell die Entwicklungen heutzutage vollzogen werden und wie komplex sie sind. „Realtime to me is a small stepping stone on the way to something bigger, faster, more effective. In terms of technology next generation will simply be today. Will be now.”

„Bei allen Überlegungen, wie sich die Welt des Kinos entwickeln wird, gingen mir immer wieder zwei Bildwelten durch den Kopf“, so Prof. Katja Schmid. „Die eine ist der Blick des kleinen Salvatore im Projektorraum in „Cinema Paradiso“ (Regie: Guiseppe Tronatore, 1988). und die andere Vision entstand beim Lesen von „Homo Deus“ (Yuval Harari) und sie dreht sich um die Frage, wie das Leben sein wird, wenn eines Tages hochintelligente Algorithmen die Menschheit besser kennen, als der Mensch sich selbst. Wird dann die Welt zum Film ? Ist das der Paradigmenshift, der maßgeblich überdenkenswert ist?“

Und neben all diesen Überlegungen geht ein herzlicher Dank an Frau Nicola Steller für die großartige Pressearbeit. Mit überlegter Schnelligkeit und Akkuratesse wurden die Interviewpartner angeschrieben und zu uns in den Presseraum geleitet. Dort trafen wir auf einen für die fmx recht stillen Ort für Dreharbeiten. Und da Nicola Steller nicht alles allein schaffen kann, danken wir herzlich allem Helfern der fmx.

Interviews wurden von Prof. Katja Schmid auf der fmx 2018 geführt.

Zur Autorin:

Katja Schmid begann als Filmemacherin in den DEFA-Studios für Trickfilme. 1993 erhielt sie ihr Diplom als Kamerafrau von der Hochschule für Film und Fernsehen in Potsdam-Babelsberg. Als Kamerafrau, Digital Artist und Editorin hat sie über 50 Film- und Medienproduktionen mitgestaltet. Seit 2004 ist sie als Professorin für Visual Effects and Postproduction an der HdM tätig. Von 2006-2011 kuratierte sie die Digital Cinema Conference, den Tech Track Stereoskopie sowie die Junior Paper Session der FMX. Von 2014 bis heute ist sie verantwortlich für das VEGA CAMP an der Hochschule der Medien. Ihre Forschungsgebiete sind Lichtfeldtechnologie und Wide Gamut.

Zum Ton:

Peter Ruhrmann trägt den Titel des Ingenieurs für Audio visuelle Medien. Er arbeitet mit Studierenden an VFX Medien Produktionen und zeigt sich verantwortlich für kreative technische Lösungen bei Herausforderung innerhalb der Produktionen. Außerdem entwickelt und wartet er seit 2006 die technische Infrastruktur des VFX Departments an der Hochschule der Medien. Peter Ruhrmann ist zertifizierter Nuke Trainer durch Foundry und fxphd. Seit 2008 unterrichtet er das Fach Compositing.

Fotos, Text, Interview: Katja Schmid

Ton: Peter Ruhrmann

Kamera: Patricia Birnfeld, Studentin der Audiovisuellen Medien an der Hochschule der Medien, Stuttgart.

Duoskin ist ein Klebetatoo mit Verbindung zu den Mobilen Geräten. Duoskin steuert durch One Touch Eingabe, Nahfeldkommunikation (Near Field Communication, abgekürzt NFC) und vermittelt thermochrome Anzeigen (Thermochromie bezeichnet man die Eigenschaft bestimmter Substanzen, bei Temperaturänderung die Farbe zu ändern). Diese Tatoos sind aus Blattgold, hauchdünn und werden auf die Haut appliziert. Sie sind relativ robust und haben einen hohen Trage Komfort. Federleicht und dabei mit der Erscheinung eines Schmuckstücks oder dergleichen.

Bildergalerie:

Sie halten einen Tag, dann werden sie abgewaschen und beim Duschen und späteren Abtrocknen entfernt. Es gibt auch welche, die schon fast zwei Wochen auf der Haut sind. Mit einfachen Touchgesten lassen sich Funktionen beim Mobile Phone durchführen: Musik wechseln, lauter, leiser, überspringen. Oder bei Präsentationen braucht es keinen Infrarot Pointer, ein Streichen in einer bestimmten Richtung reicht und die nächste Folie wird angeklickt. Wer smarte Gegenstände im Haus und Hof hat, der steuert diese an: Lampen, Schlüssel, Jalousien, Garagentore, Fenster oder ähnliches.

Diese Version ist bereits im Test, zwar wird noch an Speicher, an Akkuleistung und Microcomputer gearbeitet aber das ist eine absehbare technologische Entwicklung. Wir werden in den nächsten Jahren diese Steuerelement auf der Haut direkt tragen und sollten sie zudem eine hohe ästhetische Wirkung haben dann werden sich diese Art von Minicomputer, on skin electronics durchsetzen.

Der Designer des Interfaces und des Looks für die Tatoos von der Microsoft Research Natural Interaction Group zumindest kann von ersten Einsätzen erzählen und zeigt sich entsprechend überzeugt.

Current ist eine temporäre Medieninstallation. Es ist ein Kunstwerk im Bereich der Medienarchitektur. Dieses Werk steht an der Schwelle zwischen Kunst, Wissenschaft, Technik und Architektur. So wie wir es von David Rokeby schon in Vorläuferwerken erlebten. Wir kennen ihn eher aus projizierten Bildwelten an Architektur. Hier sehen wir eine reaktive mediale Fassade. Die Fassade reagiert auf die Umgebungseinflüsse. Sensoren erzwingen Veränderungen von an einer Fassade angebrachte Elemente. Das kann alles mögliche sein, Lichter, Scheiben, Lamellen, Roboterarme usw. alles was sich bewegen kann. Hier an diesem Beispiel werden Windrichtungszeiger, beim Segeln die Verklicker genannt, an einer Aussenfassade angebracht. Sie reagieren sensibel auf Luftänderungen. Sie stehen sie von der Fassade ab und reagieren auf jeden Luftimpuls. Fast synchron bewegen sie sich. Ein meditatives Erlebnis das dem Schwung der Wellen gleicht. Und so wird es auch von den Künstlern verstanden. Sie zeigen die unsichtbaren Wellen des Windes auf. Verwandeln die Fassade in ein Messgerät.

Das tanzende Ampelmännchen von Smart

An der Ampel auf Grün zu warten ist nicht nur für Radfahrer oder Autofahrer eine Geduldsprobe, sondern auch für Fußgänger. Man steht und starrt das Ampelmännchen an, schaut nach links und rechts, ob Kinder da sind und wenn nichts los ist, dann geht man bei Rot rüber. Gibt es eine Strategie die Passanten warten zu lassen? Kann das Warten zum Erlebnis werden, zur Unterhaltung, zu einem freudigen Moment? Es kann. Smart hat mit der Aktion #WhatAreYouFor für mehr Sicherheit auf den Straßen eine interaktive Ampelinstallation in Lissabon inszeniert.

Diese Installation bietet einmal einen Raum für Motion Capturing. Bewegungen werden abgefilmt und ich Echt Zeit auf das Ampelmännchen übertragen und entsprechend im zu erwartenden Format auf der LED-Ampel abgespielt.

Die Passanten betreten den Motion Capturing Raum, es läuft tolle Musik, sie wissen sie sollen tanzen, denn sie sehen was ihre Bewegung mit dem Ampelmännchen macht. Allein die Gewissheit, dass man nicht als Person, sondern als anonymes Ampelmännchen tanzt, bringt Freude und auch Leichtigkeit. Dennallein rumtanzen macht keinen Sinn und auch keinen Spaß, schon gar nicht auf Anhieb. Aber mit dem Wissen, welchen großartigen Effekt die Tätigkeit hat, ist ein Grund sein Bestes zu geben. Und natürlich weil der Tanzraum abgeschieden ist. Da kann man sich entfalten. Man wird nicht beobachtet.

BBDO als Werbeagentur hat sich das alles ausgedacht.

Photographie©Oliver Wedel

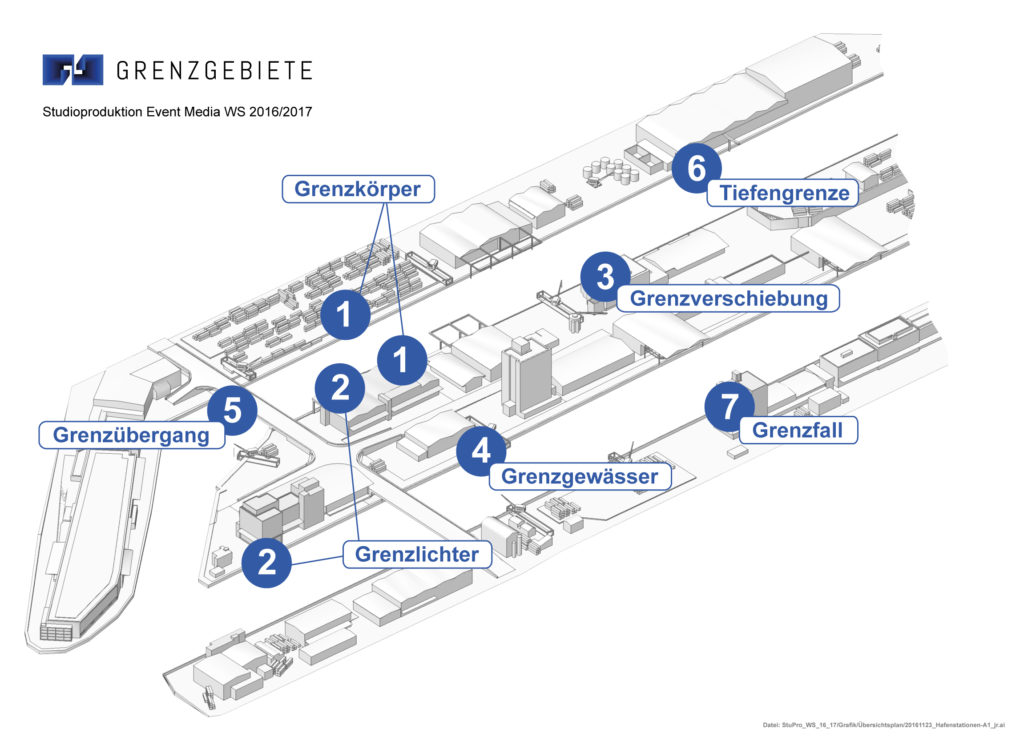

Grenzgebiete = Grenzüberschreitungen

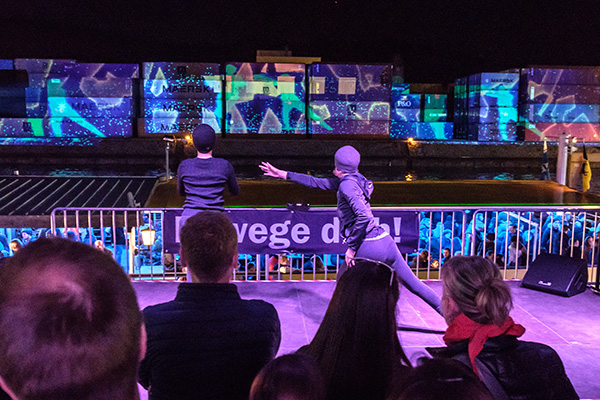

Besucher des Hafens Stuttgart tauchen an der Langen Nacht der Museen am 25.März 2017 in eine Welt der Grenzüberschreitungen ein. Sie begeben sich auf ein Schiff des Neckar-Käpt’n, das sie an sieben medialen Installationen vorbeiführt. Videomapping und Interaktive Elemente werden präsentiert.

Die zahlreichen Besucher waren von der Installation per Hafenrundfahrt begeistert. Es wurden 6500 Menschen an Land und 4500 auf den Booten gezählt. Ein Rekord.

Der Neckar verbindet Stuttgart und die Region mit dem Rest der Welt. Der Hafen inspiriert als Grenzgebiet mit seiner, urbanen, industriellen Atmosphäre immer wieder Künstler. So auch die HdM-Studenten aus dem Studiengang Audiovisuelle Medien und Medienwirtschaft. Sie beschäftigen sich in der „Studioproduktion Event Media“ unter der Leitung von Prof. Ursula Drees und Steffen Mühlhöfer mit der Inszenierung von interaktiven Erlebnisräumen. Das war am 25. März 2017 der Hafen, als Grenzgebiet für Wasser und Land, Stadt und Landkreis, Bewegung und Stillstand, Verortung und Übergang. Diese Themen inszenierten die Studenten in sieben Installationen. Die Besucher des Areals am Hafen waren von der Inszenierung zutiefst beeindruckt. Eine Besucherin: „Das Ambiente war super, durch die Kombination von Industriekulisse, nächtlicher Szene und Lichterspiel einmalig.“

Das Thema:

Grenzgebiete aus verschiedenen Blickwinkeln.

Was es ist:

Sieben multimediale Installationen im Hafen Stuttgart an der Langen Nacht der Museen. Der Besucher erlebt verschiedene Grenzüberschreitungen – in Form von optischen Illusionen oder aufgehobenen physikalischen Grenzen.

Die Stationen:

Station 1: Grenzkörper

Die interaktive Station „Grenzkörper“ ermöglicht es dem Besucher nicht nur Zuschauer zu sein, sondern selbst Teil der Installation zu werden. Sobald er die Interaktionsfläche betritt, taucht er in eine reaktive Unterwasserwelt ein und nimmt Einfluss auf seine Umgebung. Die Station befindet sich im Wartebereich der ankommenden Besucher und bezieht den Containerterminal auf der gegenüberliegenden Seite des Hafenbecken 2 mit ein.

Photographie©Oliver Wedel

Der Spieler bewegt sich durch eine polygonale Wasserstruktur in der er durch Bewegung seiner Hände Strömungen erzeugen kann, welche sich farblich von der restlichen Struktur abheben. Weitere Elemente, wie Luftblasen, die sich durch die Szenerie bewegen werden von diesen Strömungen erfasst und ändern so die Richtung ihrer Bewegung. Zudem kann der Spieler Luftblasen einfangen und herumtragen, was es ihm ermöglicht eine Luftblase auf eine von ihm festgelegte Reise durch die Unterwasserwelt zu schicken. Untermalt wird das Geschehen von einem atmosphärischen Klangteppich, sowie akustischen Highlights, die die jeweiligen Interaktionen unterstützen.

Station 2: Grenzlichter

Photographie©Oliver Wedel

Photographie©Adrain Liedtke

„Grenzlichter“ besteht aus zwei Installationen: das Grenzlicht „Land“ im Besucherzentrum und das Grenzlicht „Wasser“ auf der Bundeswasserstraße. Das „Grenzlicht“ ist ein beleuchteter Kubus mit interaktiven Elementen. Durch die Interaktion der Besucher entsteht ein Lichtfluss zwischen den zwei „Grenzlichtern“. Im Grenzlicht „Land“ werden LED röhren durch eine leichtes Berühren aktiviert. Ein Ton und ein Lichtimpuls laufen durch den Kubus und verschwinden im Wasser. Während der Schifffahrt begegnet der Besucher dem Grenzlicht „Wasser“. Hier läuft das Licht zu einem größeren Lichtkubus und im Schiff selbst wird der Ton hörbar. Sobald das Grenzlicht „Land“ betätigt wird, leuchtet das Grenzlicht „Wasser“ einige Zeit später simultan auf.

Photographie©Oliver Wedel

Station 3: Grenzverschiebung

Photographie©Oliver Wedel

Eine Fassaden-Projektion zum Innenleben eines Gebäudes. Das interessierte uns immer schon: wie ein Gebäude sieht und fühlt.

Station 4: Grenzgewässer

Photographie©Adrain Liedtke

Ein endlicher Strom aus Farben und Bewegung wird auf eine Wasserwand projiziert.

Station 5: Grenzübergang

Das Schiff fährt unter einer Brücke hindurch: Es überquert die Grenze vom Hafenbecken 1 zum Bundeswasserstrasse 1. Beim Durchfahren ändert sich die Lichtstimmung im Schiff, gleichzeitig wird der Grenzübergang an der Brücke markiert. Das Licht ändert sich simultan zum Innenlicht. Auf dem Boot wird mit Ton die Annäherung über Sensortechnik zu hören sein.

Photographie©Oliver Wedel

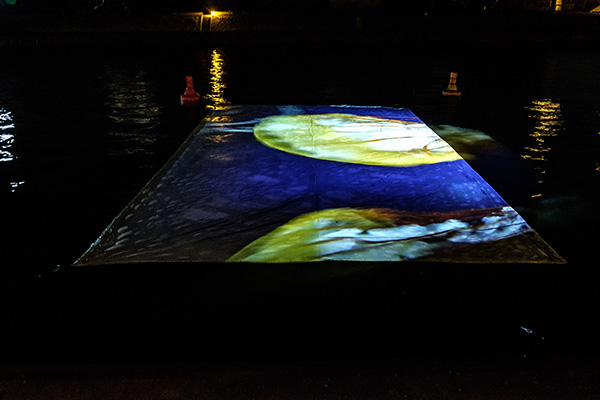

Station 6: Tiefengrenze

Die Idee der Station Tiefengrenze ist die Sicht des Besuchers umzukehren und dabei die Grenze der Wasseroberfläche zu überschreiten.

Der Besucher wird vom Schiff aus hinunter auf eine 240 Quadratmeter große Projektionsfläche schauen. Sie ist im Wasser eingeladen, bei der Fahrt wird einleichter Wellengang die Illusion einer anderen Unterwasserwelt unterstützen. Gezeigt wird deine fremde Unterwasserwelt, eine die nicht im Neckar zu erwarten ist. Da schwimmen Qualle, Häire, Riesenschildkröten, Tropische Fische oder Muränen durch das Wasser.

Photographie©Oliver Wedel

Station 7: Grenzfall

Hier werden die Grenzen der Schwerkraft überschritten. Dafür wird die Schwerkraft für das Element Wasser aufgehoben und umgekehrt. Es ist eine Fassadenprojektion.

Photographie©Oliver Wedel

Techniken:

Projektion

3x DLP_Panasonic PT-DZ21K W-UXGA + Optik (2,4-4,7)

Rechner/Peripherie:

2x Computer Soundkarten extern M-Audio Profire 2626, 3x Laptop

Software

Ableton Live Suite 9.7, Adobe CC, DaVinci Resolve 12, Houdini FX (Side FX, Kinect Runtime, Maxon Cinema 4d, Restart on Crash, Soundkarten-Treiber, VLC-Player, Voronoi-Algorithmus, VVVV, VVVV, DX11 Pointcloud Addon, Windows 10

Medientechnik/-steuerung

9x Shure ULX-D4DE K51 Doppelempfänger + 6 aktive Richtantennen, 5x Shure ULX-D1 K51 Taschensender + Klinkenadapter + Stativ + Batterien, Strom/XLR/BNC-Verkabelung

Audio

26x FOHHN AL-10 ultrakompaktes Design-Lautsprechersystem, XLR-Adapter, Manfrotto-Superklemmen, Flugrahmen (FOHHN), 4x FOHHN AS-10 Bassboxen, 4x Powersoft DIGAM M28Q DSP 4-Kanalendstufe in Rack, Motu UltraLite USB Audiointerface

Lichttechnik

LED-Scheinwerfer LITECRAFT LED PAR AT10 (18x10W), MA Lightcommander (12/2)

Team:

Bildergalerie:

| Studiengang | Vorname | Nachname |

|---|---|---|

| AMB | Aline | Müller |

| AMB | Bodo | Lohr |

| AMB | Dorian | Sorg |

| AMB | Elena | Kalinka |

| AMB | Levin | Frenzel |

| AMB | Lucas | Aue |

| AMB | Marcus | Streiter |

| AMB | Tim | Dieckmann |

| AMB | Mareike | Maass - Rebholz |

| MWB | Luca | Jungemann |

| MWB | Michaela Anna | Hönig |

| Tutor | Johannes | Raff |

| IT Beratung | Nadja | Weber |