Category Archives: application

©DEZEEN_ Tim Cannon

Biohacker Tim Cannon implantiert einen Device, übrigens mit Hille eines Freundes ohne Betäubung und ärztliche Hilfe, da diese dazu nicht autorisiert sind, direkt unter seine Haut. Die Vorgehensweise ist so wie das Bild: Selbstgemacht und einigermassen hausbacken. Aber es kommt nicht auf die Schönheit des Eingriffs an, es geht um eine weitere Verschmelzung von Mensch und Maschine. Dieser Device kann die biometrischen Daten auf ein Android Tablet mit Bluetooth übertragen und so werden Änderungen der Körpertemperatur, erhöhte Temperatur und Schweissproduktion erfassen. Die Daten werden gespeichert und damit lässt sich dann eine Selbststatistik erstellen, die dazu führt, bestimmte Verhaltensweisen zu erkennen und wenn notwendig seinen Lebensstil zu ändern. Der Deivice wurde von seiner Firma Grindhouse Wetware gebaut. Der Device mit dem Namen Circadia 1.0 beinhaltet einen Computer Chip in einer versiegelten kleinen Box, die ungefähr die Grösse einen Kartenspiels hat. Das ganze wird durch eine Batterie wireless aufgeladen.

Wer mehr erfahren will der sollte auf You Tube: „Experimenting with biochip implants“ ansehen.

Tim Cannon will seinen Körper besser verstehen, will intensiver auf dessen Signale hören und achten. Er findet die Aussenwelt, Umwelt sollte eine erhöhte Bereitschaft zu Selbstwahrnehmung aufweisen. (Cannon im tech Blog Motherboard). Bei eine stressigen Tag, so seine Vision, wird der Chip die Daten nach Hause senden und eine entspannungsfördernde Atmosphäre vorbereiten. Vielleicht die Lichter runter fahren und ein Bad einlassen.

©DEZEEN_ Tim Cannon

„I think that our environment should listen more accurately and more intuitively to what’s happening in our body,“ „So if, for example, I’ve had a stressful day, the Circadia will communicate that to my house and will prepare a nice relaxing atmosphere for when I get home: dim the lights, let in a hot bath.“

LED’s sind Teil des kleinen Devices und bei Verbindung mit dem Tablet, leuchten sie auf und erhellen Tim Cannons Tatoo. Die Circadia 1.0 wird wohl für $500 (£314) in den nächsten Monaten erhältlich sein. Cannon arbeitet wohl gerade an einer etwas kleineren Version, der auch eine Pulsmessfunktion beinhaltet.

©DEZEEN_ Tim Cannon

Tim Cannon hat einen Schritt in Richtung Cyborg, Mensch-Maschine Verbindung gemacht. Der Schritt ist ziemlich rabiat und ich frage mich, ob ich auch in einigen Jahren einen solchen Device unter der Haut trage. Durchaus vorstellbar sollte sich das Verfahren etwas wenige rabiat gestalten und das Resultat ästhetisch ansprechender sein. Es sieht nach Schmerzen aus.

Beitrag von Ursula Drees

©URBAN SCREEN_ Searchlight, Studie zum Moving Head Projektor und Projektions Mapping

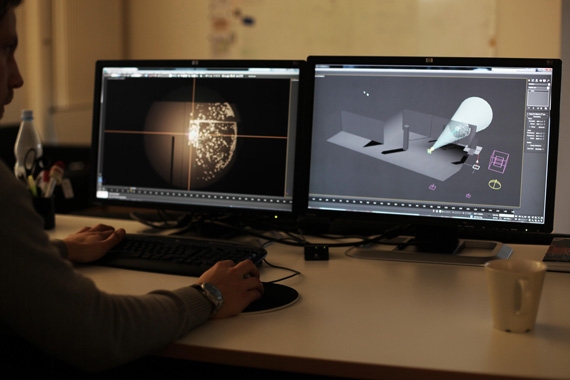

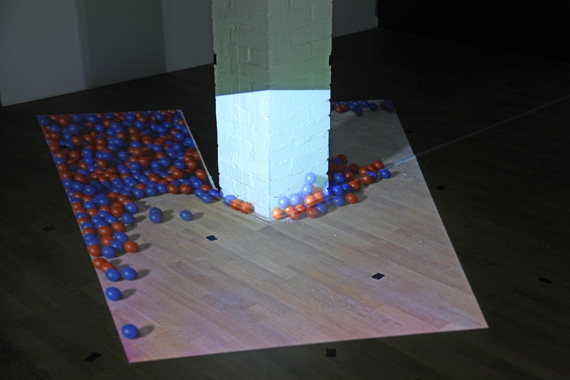

URBAN SCREEN zeigt in diesem Dokumentationsvideo eine experimentale Studie zu Projektionen mit einem Moving Head Projektor. Der Ursprungsraum, eine Fabrikhalle ist in erster Linie gross und zeigt die üblichen baulichen Identifikationselemente einer Industrie genutzten Halle: rechteckige Balkenverkleidungen, Holzboden oder Beton, Kargheit, statische Säulen und sonst nicht viel, bis auf Türen oder Fenster. Die sind aber abgedunkelt deshalb sieht man sie nicht sofort.

Die Studie, so URBAN SCREEN, hatte vor allem den Charakter einer technischen Auseinandersetzung. Es ging in erster Linie darum, einen Moving Head Projektor in ein Projektions Mapping Set Up einzubinden. Narratives Potential, Inhalte oder ähnliches spielen noch keine Rolle. Es soll herausgefunden werden, wie so was geht und was dabei raus kommt. Der Rest kann später hinzu kommen.

©URBAN SCREEN_ Searchlight, Studie zum Moving Head Projektor und Projektions Mapping

Und kommt etwas dabei heraus? Die Erkenntnis dass tatsächlich erzählt werden kann, dass andere Geschichten und Gefühle transportiert werden und alles durch die technische Herangehensweise. URBAN SCREEN, darauf brauchen wir wahrscheinlich nicht besonders lange zu warten, wird bei der nächsten Gelegenheit die Technik einsetzen, dann aber mit allem was noch dazu gehört. Wir sind gespannt, denn die Resultate sind schon bei der Spielerei und bei Experiment vielversprechend.

©URBAN SCREEN_ Searchlight, Studie zum Moving Head Projektor und Projektions Mapping

Hier die Specs:

Production: January 2013 – May 2013

Project Manager: Till Botterweck, Thorsten Bauer

Art Director: Till Botterweck, Julian Hoelscher, Max Negrelli

3D Designer: Peter Pflug, Moritz Horn

Producer: Manuel Engels

Media Engineer: Tobias Wursthorn (im-en.com)

Documentation Director: Till Botterweck, Thorsten Bauer

On-Site Camera: Max Negrelli, Moritz Horn

Edit: Max Negrelli

Music: Jonas Wiese (jonas-wiese.de)

Moving Head Projector support: Publitec (publitec.tv)

3D Scan support: Leica Geosystems (leica-geosystems.de)

Media-Engine support: WINGS VIOSO (avstumpfl.com)

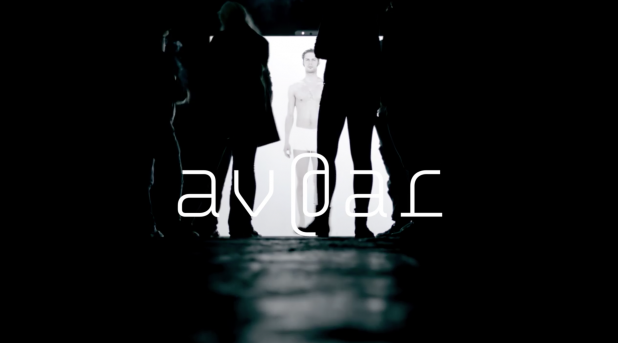

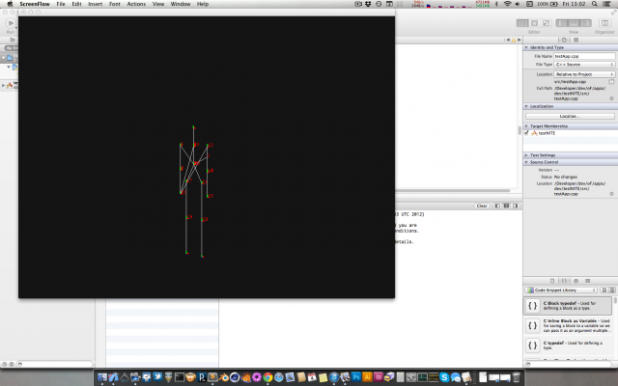

©av@ar von Manfred Borsch, interaktive Installation mit Gestenerkennung

Wir stellen die Diplomarbeit von Manfred Borsch, videograph, mit dem Titel „av@ar“ vor. Sie entstand am Institut Für Musik Und Medien. Herr Borsch hat nach der ersten Sicht freundlicherweise in einem online Interview Hintergrundfragen beantwortet. Mit diesem Wissen steigt der Genuss am Werk. es ist poetisch und hintergründig. Hintergründig weil die Interaktion sowohl aktiv als auch inhaltlich erarbeitet wird. Wer nicht genau hinschaut kann die Tiefe des Werks übersehen. Und das wäre schade.

UD: „Wie wird die Gestenerkennung gemacht? Haben sie Kinects eingesetzt? Wird Mimik abgenommen? Wenn ja, wie haben sie das technisch gelöst?“

MB: Die Gestenerkennung ist wie von Ihnen richtig vermutet mit einer Kinect, OpenNI mit NITE Middleware und der Programmierungsumgebung Max/MSP/Jiitter realisiert worden. Die Mimik wird nicht durch die Kamera aufgenommen, trägt jedoch thematisch zum geschlossenen Kreislauf der Installation bei.

Als Avatar wurde ein Mensch (und eben nicht eine digitale Form, wie beispielsweise eine Pixelansammlungen) gewählt, da durch Spiegelneuronen die Bindung zwischen BesucherIn und Abbild erhöht wird. Hierzu zählt auch das (teils unbewusste) Nachahmen von Emotionen mit der Gesichtsmuskulatur. Da alle Auswirkungen des Handelns in der Installation erforscht werden sollen, es also keine Spielanleitung o.ä. gibt, ist den InterakteurInnen zu Beginn nicht bekannt, ob sie auch mit ihrer Mimik einen Einfluss auf das Geschehen haben.

Diese Abhängigkeiten können im geschlossenen Kreislauf erkundet werden, was sich auf die Wechselseitigkeit von Körper (Interface) und Emotionen (audiovisuelle Reaktionen) gründet.

Bekannt ist die Richtung, dass Emotionen erlebt werden und sich daraufhin das Körperliche verändert, beispielsweise in der Gesichtsmuskulatur, die sich zu einem Lachen hin verzieht. Dies beschreibt beispielsweise Paul Ekman mit dem Facial Action Coding System. Andersherum zeigt die Kognitionswissenschaft im Forschungszweig Embodiment, dass Gefühle auch nach der körperlichen Regung erzeugt werden können. Ein bekanntest Beispiel hierzu ist der quer in den Mund genommene Bleistift, der zur Anspannung von Muskeln im Gesicht führt, die eigentlich zum Lächeln benutzt werden. Forschungen haben ergeben, dass ein solcher, emotional unbewusster, äußerer Einfluss zu deutlich positiveren Bewertungen von Situationen führt, als bei der neutralen Vergleichsgruppe.

©av@ar von Manfred Borsch, interaktive Installation mit Gestenerkennung

Generell steht in der Installation die Frage der Kontrolle, der Auswirkung, im Mittelpunkt. Was kann ich direkt kontrollieren? Wo erlebe ich Kontrollverlust? (zufällige Fehler zur Kontrollminderung sind vorhanden.) Und in wieweit werde ich kontrolliert/geleitet, also wonach richte ich mein Handeln aus. Diese durch die Überlagerung der Rezeptions- und Handlungsebene sehr individuelle Erfahrung kann zur Reflexion über eigene Handlungsziele führen. Beispielsweise kann ich erlernte Körperhaltungen wiederholen, um dem umherstehenden Publikum zu zeigen, dass ich Kontrolle ausübe, ich kann mich auf die Suche nach neuen Bildern und Tönen machen, ich kann die Synchronität der Bilder und der Musik in den Mittelpunkt stellen (VJing) oder mich zu der Musik bewegen, die ich durch meine Bewegung selber schaffe.

UD: Wie viele Reaktionen des medialen Ichs wurden vorproduziert?

MB: Es gibt 16 Einzelemotionen, die in vier Gruppen, den sogenannten Basisemotionen unterteilt sind. Mehr dazu unten… 🙂

Mit dem Überbegriff der Basisemotion versehen, werden die Emotionen wie folgt gruppiert:

Angst, Neid, Scham, Trauer: negative Emotion, passives Verhalten

Freude, Bewunderung, Stolz, Glück: positive Emotion, aktives Verhalten

Liebe, Mitleid, Dankbarkeit, Hoffnung: positive Emotion, passives Verhalten

Hass, Verachtung, Ärger, Verzweiflung: negative Emotion, aktives Verhalten.

©av@ar von Manfred Borsch, interaktive Installation mit Gestenerkennung

UD: Gibt es eine Relation zwischen den Einstellungsgrössen und den Besucheraktivitäten. Wann wird eine Detail oder Gross Einstellung genommen wann Halbtotale oder Totale?

MB: Es gibt eine mögliche Raum- und eine Körpererfahrung.

Der Raum kann in seiner Tiefe (Abstand der AkteurInnen zur Leinwand) erforscht werden, worauf sich die mediale Reflexion nach der Proxemik (E.T. Hall) in vier Stufen anpasst. Dies ist eingeteilt in die öffentliche Distanz (> 3m), gesellschaftlich-wirtschaftliche Distanz (1,5-3m), persönliche Distanz (0,5-1,5m) und die intime Distanz (< 0,5m) und wird so auch visuell Abgebildet (tief im Raum, als Spiegelsituation, Portraitdarstellung und Detailaufnahme. Je kleiner der Abstand, desto dezenter die dargestellte Emotion). Der Raum kann auch im Volumen erfahren werden, ausschlaggebend hierfür ist die durchschnittliche Höhe beider Hände. Hier können die vier Basisemotionen angesprochen werden. (Bsp.: Befinden sich beide Hände über der Kopfhöhe, wird die Basisemotion Angst angesprochen. Befindet sich der Akteur sehr nah vor der Leinwand, erscheint die Detailaufnahme – intime Distanz – des sich aufreißenden Auges). So ist der Raum mit vier Basisemtionen komplett abgedeckt.

Darüber hinaus können die weiteren 12 (Sekundär-)Emotionen durch bestimmte Körperhaltungen angetriggert werden. Hierbei muss erforscht werden, welche Körperhaltung zu welcher audiovisuellen Reaktion führt. (Bsp.: Beide Hände auf die Hüften gestützt, Oberkörper aufrecht -> Emotion Stolz). Auch diese Sekundäremotionen sind auf den vier verschiedenen Distanzebenen darstellbar, sodass es insgesamt (16×4) 64 vorproduzierte visuelle Reaktionen gibt.

©av@ar von Manfred Borsch, interaktive Installation mit Gestenerkennung

UD: Reagiert die Musik auch?

MB: Die Musik reagiert ebenso auf das Handeln der AkteurInnen, entzieht sich jedoch zum Teil durch Statistiken. Die Komposition unterteilt sich in vier Ebenen, die stets zusammen erklingen, und sich auf die vier deutschen Begriffe zur Emotion gründen. (Affekt, Gefühl, Emotion und Stimmung: je kürzer die Emotion, desto Objektbezogener. Ein Affekt (sehr kurz) ist somit sehr objektbezogen.) Die oberste musikalische Ebene (Affekt-Ebene) ist direkt an das Bild gekoppelt und kann zu jedem Zeitpunkt angespielt werden. Sie verton sehr genau alle 64 dargestellten Bilder. Die darunter liegende Gefühlsebene ist doppelt so lang (zwei Takte), berechnet sich aus dem Durchschnitt der zuvor angetriggerten Affekten und stellt die 16 Emotionen dar. Ebene drei (Emotionsebene) ist wiederum länger (vier Takte), wird aus dem Durchschnitt der angespielten Affekten berechnet und vertont die vier Emotionsgruppen (s.o.). Die längste Ebene (Stimmungsebene) unterscheidet nur noch zwischen positiv-annähernd und negativ-ablehnend (der emotionalen Grundtendenzen Neugeborener nach) und ergibt sich aus den Handlungen der letzten acht Takten (ca. 26 Sekunden).

Die musikalische Komposition (Tonart, Rhythmus, Melodie,..) bezieht sich hierbei auf die Affektenlehre des Barock, ein Regelwerk, dass sehr klare Vorgaben zur Vertonung von Emotionen vorsah, sich also sehr gut in den Grundcharakter der Installation einfügt, in der etwas sehr Menschliches wie Emotionen radikal in Gruppen einsortiert, systematisiert und damit abrufbar gemacht wird.

Ich bedanke mich für die inhaltsvollen und Erkenntnis unterstützenden Antworten!

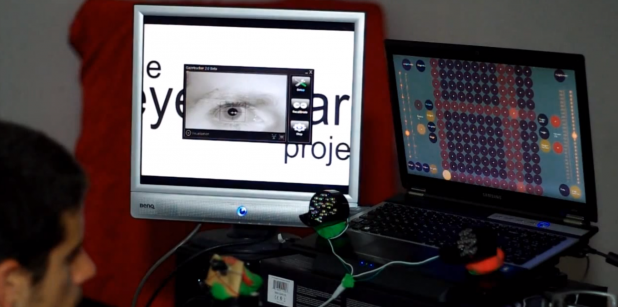

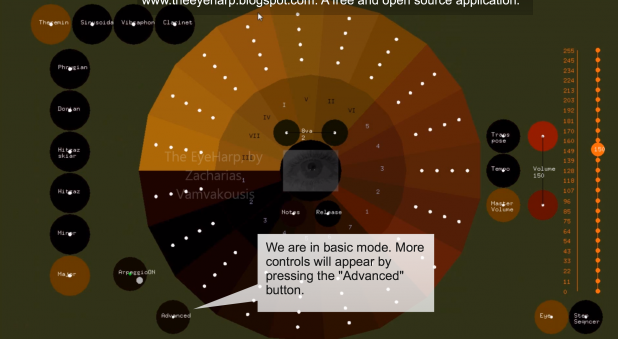

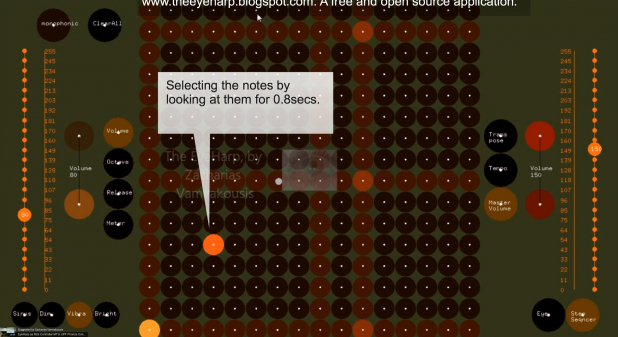

© EyeHarp_ a new Interface for Musical Expression_2012_ Zacharias Vamvakousis

Die Bewegung der Iris wird abgenommen und auf eine Musiklibrary übertragen. Mit anderen Worten, die Bewegung der Iris komponiert Musik. Der Video zeigt die Besucher auf der NIME 2012 Konferenz in Detroit. Für die Programmierung wurde ITU Gazetracker Open Source Eye Tracking Software verwendet. Zacharias Vamvakousis, Athens, Greece, PhD Kandidat am MTG, UPF, Barcelona hat diese Software getriebene Musiksteuerung entwickelt. Supervisor: Dr. Rafael Ramirez.

Mehr unter http://www.youtube.com/watch?v=d8OanafChKs

© EyeHarp_ a new Interface for Musical Expression_2012_ Zacharias Vamvakousis

© EyeHarp_ a new Interface for Musical Expression_2012_ Zacharias Vamvakousis

Das Eyeharp Projekt will Menschen mit Lähmungen durch Amyotrophic Lateral Sclerosis eine Steuerung für Musik ermöglichen. Das Instrument kann alternativ auch durch jeden anderen Controller oder Device beitreiben werden. Am einfachsten durch eine Maus. Es kann ein Musikinstrument für Menschen mit unterschiedlichen Behinderungen sein. Eyeharp wird in openframeworks v0.6 implementiert.

© EyeHarp_ a new Interface for Musical Expression_2012_ Zacharias Vamvakousis

© EyeHarp_ a new Interface for Musical Expression_2012_ Zacharias Vamvakousis

Beitrag von Ursula Drees

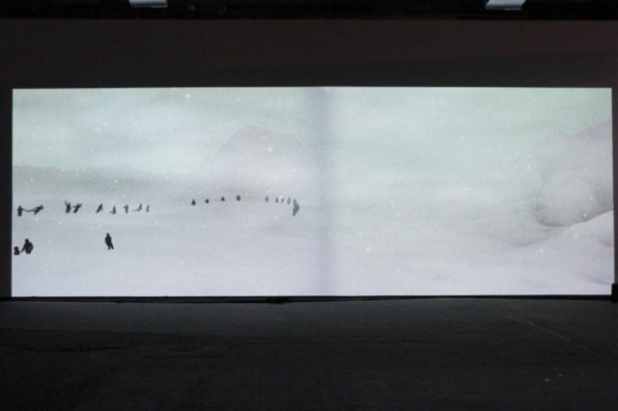

© creative application und Thomas Eberwein / Thomas Traum und Tim Gfrerer

Gemacht wurde Ghost von Thomas Eberwein / Thomas Traum und Tim Gfrerer. In Ghost geht es um einen interaktiven Schneesturm, ein wüstes Naturereignis durch eine verlassene und karge Landschaft. Der Besucher findet sich in diesem Szenario wieder und muss sich retten. Wie kommt er heraus, ist er verloren und wird er den Kampf um Leben und Tod verlieren? Die Körper der vorherigen Besucher säumen seinen Weg und sein Bemühen. Ein unheimliches Umfeld.

Mehr unter http://thomastraum.com/#works/ghost/

© creative application und Thomas Eberwein / Thomas Traum und Tim Gfrerer

© creative application und Thomas Eberwein / Thomas Traum und Tim Gfrerer

Man sieht die Landschaft aus der Sicht eines überfliegendes Auges (Kamera), unterbrochen von einer Reihe vorproduzierter Stimmungen. Die Landschaft und die Stimmung beeinflussen die Intensität des Sturms, die Musik, die Farbe des Nebels und die Geräusche. Die Szenerie kann von intensiv, laut und aggressiv zu einem fast schon friedlichen, leisen Schneegestöber wechseln. Wird ein Besucher registriert, bewegt sich die Kamera auf ihn zu. Man sieht eine Reihe Naheinstellungen des Umfelds. Wenn niemand mit dem Werk interagiert, wechselt die Kamera auf Panoramaeinsteillungen, die auf ewig gefangene Geister der vorherigen Besucher zeigen.

© creative application und Thomas Eberwein / Thomas Traum und Tim Gfrerer

© creative application und Thomas Eberwein / Thomas Traum und Tim Gfrerer

© creative application und Thomas Eberwein / Thomas Traum und Tim Gfrerer

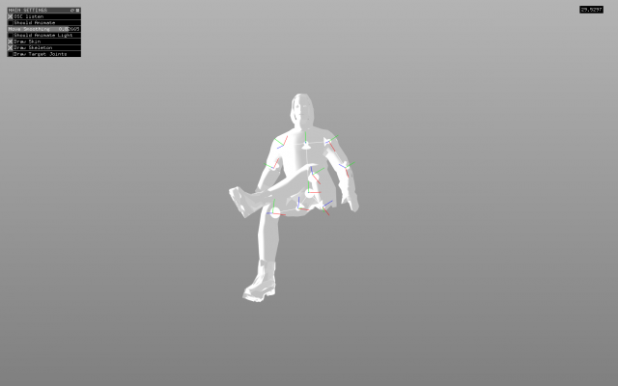

Die Installation wurde mit openFrameworks gemacht. Landschaft und Charaktere in einer 3D Modelling Software. Die über das menschliche Skelett abgeleiteten Bewegungen sind entworfen und neu programmiert. Besucherbewegungen werden ebenso von ihren Skeletten abgeleitet und mit der Open Source Software OpenNI framework aufgezeichnet. Die Daten werden mit OpenNI (Open Source Software) in die Hauptapplikation eingespeist. Dort findet das Einfügen der Bewegungen statt, und gleichzeitig eine Umwandlungen in Geister für spätere Verwendung in den leeren Landschaften. Die atmosphärischen Komponenten wie Farbe, Windgeschwindigkeit, Wolken, Nebel und Schneeintensität sind mit der Musik abgestimmt.

© creative application und Thomas Eberwein / Thomas Traum und Tim Gfrerer

© creative application und Thomas Eberwein / Thomas Traum und Tim Gfrerer

Spezielle GLSL shaders übernehmen die Charakter Animation. Sie werden in real time abgespielt und entwickelt um bis zu 100 Geister gleichzeitig animieren zu können. Gut 400 MB Skelettanimationen entstanden dabei. Sie werden in späteren Projekten und Einsätzen von Ghost verwendet.

Ghost entstand als Thomas Eberwein als Interactions Designer beim EPFL+ECAL Lab in Lausanne, Switzerland tätig war. Es ist eine Auftragsarbeit für die Ausstellung mit dem Titel “Give Me More” vom EPFL+ECAL Lab in der Eyebeam gallery in NYC im Frühjahr 2013. Die Musik kommt von Freefarm.

© creative application und Thomas Eberwein / Thomas Traum und Tim Gfrerer

http://www.creativeapplications.net

Autor von Creative Applications: Filip Visnjic

Beitrag in Deutsch von Ursula Drees