Category Archives: Performance

©Daniel Michelis

Es geht um ein interaktives Display im öffentlichen Raum. Einerseits beschäftigt sich das Display mit der Bewegung auf dem Bildschirm, andrerseits mit der Interaktion der Passanten. Bis hier ist alles wie immer. Auch der Fragenkatalog in diesem Zusammenhang ist bekannt: Machen interaktive Display im öffentlichen Raum Sinn? Können sie zu Werbezwecken eingesetzt werden? Werden sie vielleicht eher zu städtischen Punkten um anzuhalten und zu spielen? Ohne direkte Werbeaussage? Markieren sie vielleicht später wichtige Areale im Stadtbild? Anders gesagt: werden interaktive Grossdisplays eine weiter reichende Funktion als nur reine Aufmerksamkeitserreger sein? Werden sie vielleicht zu einem Sprachrohr für Gesellschaft, Politik, Bürgerbegehren oder Diskussionsschnittstellen? Mit dieser Installation wurde eine akademische Studie durchgeführt. Es soll die erste dieser Art sein. Wir haben sie der Universität von Anhalt zu verdanken. Umgesetzt hat die Installation die Universität der Künste, die Studie und Idee kam von Daniel Michels. Die Installation bietet unterschiedlichen Stadien der Einbindung an.

©Daniel Michelis

Progression: Wachstum von Blumen. Der Passant lässt mit Bewegung Blumen wachsen.

©Daniel Michelis

Flexibilität mit Bewegung schreiben.

©Daniel Michelis

Luminary: Lichtschweif hinterherziehen. Ein hübscher Effekt.

©Daniel Michelis

Aura: Lichtumrahmung der Silhouette, ein weiterer hübscher Effekt.

Wenn ich die Inhalte beurteile, das was der Passant tatsächlich hervorruft mit seiner Interaktion, wirkt die Installation wenig überraschend. Das bringt nicht zum Denken eher zum Spielen und lachen. Soll nicht schlecht sein, natürlich, aber ist das genug um Interaktion im rahm zu untersuchen? Wenn der Mensch nicht gefordert wird, nicht nur mit Bewegung dann nehme ich an, vergleicht er die Effekte, geniesst sie für den Moment, geht weiter und hat was neben einem recht Netten Erlebnis nichts mitgenommen. wie würde eine Studie ausfallen, wenn nicht nur Bewegung von Passanten untersucht wird, sondern auch der Inhalt? Wie würde gemessen? Verweildauer, allein oder zu mehreren, sinnenhaftes Tun? Schwer zu sagen. Das wird wohl noch kommen in den nächsten Jahren.

©Daniel Michelis

©ICT_HDM_StudioProduktion Event Media

„PsychoPath“

Das Projekt der Studioproduktion Event Media „PsychoPath“ ist eine interaktive, 6 (Breite) x 4 (Höhe) m Kletterwand und gleichzeitig Spiel. Kletterwände werden im Fachjargon Boulderwände genannt. Bouldern ist horizontales Klettern in geringer Höhe, wodurch aufwändige Sicherheitsmaßnahmen entfallen. Eine Boulderwand (engl. Boulder = Felsblock) ist eine künstlich eingerichtete Kletterwand, die ohne Seilsicherung beklettert werden darf.

Das Magazin PLOT berichtet ebenfalls.

Die Geschichte des Spiels „PsychoPath“–Klettere auf dem Pfad zwischen Wahnsinn und Genesung!

Peter ist kurz davor, den Verstand zu verlieren. Seine Neuronen sind Klettersteine und sie infizieren sich. Schnell. Sehr schnell. Die blauen Steine sind gesund, die roten jedoch müssen geheilt werden. Dazu reicht eine Berührung. Aber wird es in der vorgegebenen Zeit möglich sein, alle zu erreichen?

Es gilt in einem festgelegten Zeitraum alle Klettersteine zu berühren, damit sie gesunden. 2 Spieler sind beteiligt. Ein Spieler klettert, der andere gibt Anweisungen. Die hinter der transparenten Kletterwand aufgestellte LED Powerwall zeigt die infizierten und gesundeten Neuronen. Der Kletterer wird durch den Helfer zu den infizierten Steinen geleitet. Ausserdem darf ein Auswechseln der Kletterer durchgeführt werden.

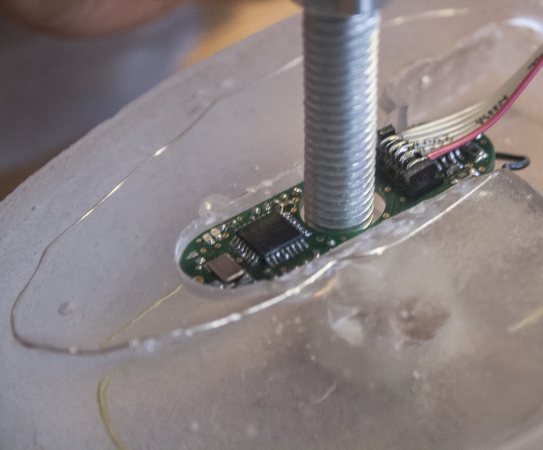

Jeder Kletterstein ist mit einem Touchsensor, mit einem Microcontroller und RGB LED Lichtern ausgestattet. Die Berührungen der Hände und Füsse werden gemessen. Ein Impulssignal wird an ein LED Licht im Kletterstein geschickt. Gleichzeitig werden Daten an eine hinter einer aus Plexiglas gefertigten Kletterwand befindliche eine LED Wand weitergeleitet.

©ICT_HDM_StudioProduktion Event Media

Die Klettersteine sind Einzelanfertigungen. Sie weisen eine Verdrahtung zur Berührungswahrnehmung im Stein auf. Ausserdem befindet sich ein eigen für diese Wand entwickelter Microcontroller in jedem einzelnen Stein. Das Institut für Polymerchemie (IPOC) an der Uni Stuttgart hat uns ihre Labore für den Guss zur Verfügung gestellt.

Die Microcontroller sind für die Datenvermittlung verantwortlich. Felix Hundhausen, Student der Mechatronic der Hochschule Esslingen-Göttingen im Fachbereich Electronic hat uns massgeblich mit der Entwicklung unterstützt. Die Platine wurde geätzt, bestückt, verkabelt und mit einem Programm bespielt.

©ICT_HDM_StudioProduktion Event Media

Ebenso hat das ILEK Institut für Leichtbau Entwerfen und Konstruieren (ILEK) der Universität Stuttgart bei der Statik der Wand beraten.

Die interaktiven Klettersteine als auch der Microcontroller sind eigenständige Entwicklungen. Sie sind im wahrsten Sinne des Wortes angewandte Forschungsprojekte. Genauso verhält es sich mit der Kletterwand als Konzept. Bis jetzt gibt es weltweit keine Kletterwand die als interaktives Spiel funktioniert.

„Für dieses Projekt wurde alles bewegt. Wir haben Kooperationen mit dem Institut für Polymerchemie (IPOC), dem ILEK Institut für Leichtbau Entwerfen und Konstruieren an der Uni Stuttgart, der Hochschule Esslingen-Göttingen Fachbereich Electronic erwirkt. Ausserdem haben wir interdisziplinär mit den Fachbereichen Medienwirtschaft und Medieninformatik, Game Development, Software Engineering unter der Leitung von Stefan Radicke an der Hochschule der Medien zusammen gearbeitet. Das spricht für die Komplexität und den Anspruch des Projekts“, so Ursula Drees, betreuende Professorin der Produktion

„Die Idee ist aussergewöhnlich! Eine interaktive Kletterwand, die auch gleichzeitig ein Spiel ist, gibt es weltweit noch nicht. Das ist eine Sache. Die Entwicklung der Klettersteine und der Microcontroller als eigenständige angewandte Forschungsprojekte stellt eine andere Sache dar. Das ist herausragend.“

©ICT_HDM_StudioProduktion Event Media

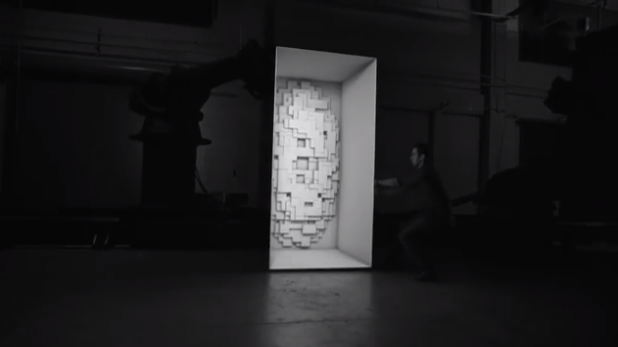

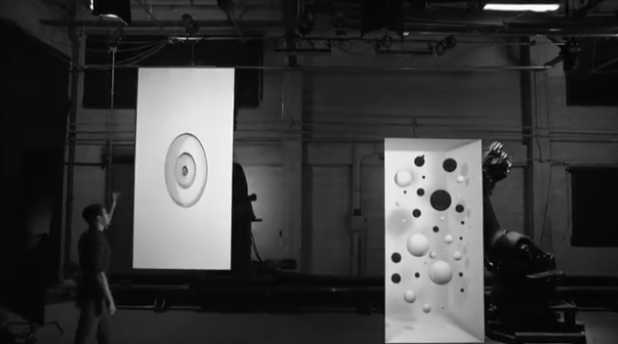

Tarik Abdel-Gawad, Creative & Technical Director und Bradley G Munkowitz, Design Director: BOX. Photo©Bot&Dolly

Bot & Dolly’s ist eine Agentur für Design und Technik, in San Francisco. Sie haben ein Faible für Technik und Bewegung, Projektion und Illusion. Wer hat das nicht? Mit der Installation BOX haben sie 2 KUKA Industrieroboter, bewegte rechteckige Wände und einen Projektor als Grundlagenmaterial verwendet. Darauf werden CG’s projiziert. Einfache visuelle Täuschungen wie wir sie vom Projektions Mapping kennen. Licht und Schatten Spiele, mit eckigen und runden Formen. Sie treten scheinbar heraus, werden zurück gedrückt, hinterlassen Abdrücke, formen Wege und Tunnel und ausgestellte architektonische Formen. Ein zweiter Projektor ist auf den Boden gerichtet und alles zusammen wird durch einen Schauspieler vervollständigt. Der scheint die von den Industrierobotern bewegte Wände zu tragen, heben, schieben oder drücken. Seine Bewegungen spiegeln die Projizierten Formen in den Wänden wieder. Spielerisch, leichtfüssig, elegant und gleitend. Das wiederum wird mit einer 4 K Kamera, die wiederum auf einen 3 KUKA Roboter angebracht ist aufgenommen. Der ist mit den anderen Robotern synchronisiert. Ein grossartiges Schauspiel. Illusion auf der höchsten Stufe. Es ist eine künstlerische als auch technische Ansage.

Tarik Abdel-Gawad, Creative & Technical Director und Bradley G Munkowitz, Design Director: BOX. Photo©Bot&Dolly

mehr auf http://www.engadget.com/2013/09/24/bot-and-dolly-box/

<iframe width=“560″ height=“315″ src=“//www.youtube.com/embed/lX6JcybgDFo“ frameborder=“0″ allowfullscreen></iframe>

Beitrag von ursula drees

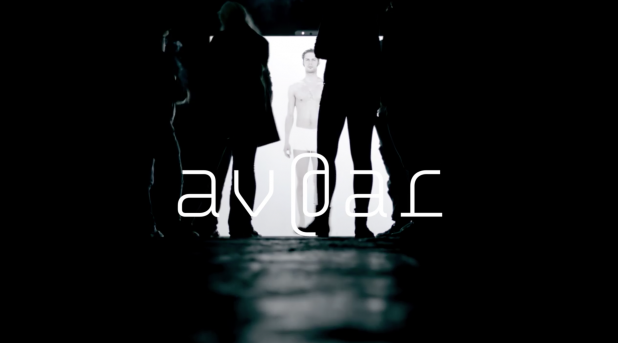

©av@ar von Manfred Borsch, interaktive Installation mit Gestenerkennung

Wir stellen die Diplomarbeit von Manfred Borsch, videograph, mit dem Titel „av@ar“ vor. Sie entstand am Institut Für Musik Und Medien. Herr Borsch hat nach der ersten Sicht freundlicherweise in einem online Interview Hintergrundfragen beantwortet. Mit diesem Wissen steigt der Genuss am Werk. es ist poetisch und hintergründig. Hintergründig weil die Interaktion sowohl aktiv als auch inhaltlich erarbeitet wird. Wer nicht genau hinschaut kann die Tiefe des Werks übersehen. Und das wäre schade.

UD: „Wie wird die Gestenerkennung gemacht? Haben sie Kinects eingesetzt? Wird Mimik abgenommen? Wenn ja, wie haben sie das technisch gelöst?“

MB: Die Gestenerkennung ist wie von Ihnen richtig vermutet mit einer Kinect, OpenNI mit NITE Middleware und der Programmierungsumgebung Max/MSP/Jiitter realisiert worden. Die Mimik wird nicht durch die Kamera aufgenommen, trägt jedoch thematisch zum geschlossenen Kreislauf der Installation bei.

Als Avatar wurde ein Mensch (und eben nicht eine digitale Form, wie beispielsweise eine Pixelansammlungen) gewählt, da durch Spiegelneuronen die Bindung zwischen BesucherIn und Abbild erhöht wird. Hierzu zählt auch das (teils unbewusste) Nachahmen von Emotionen mit der Gesichtsmuskulatur. Da alle Auswirkungen des Handelns in der Installation erforscht werden sollen, es also keine Spielanleitung o.ä. gibt, ist den InterakteurInnen zu Beginn nicht bekannt, ob sie auch mit ihrer Mimik einen Einfluss auf das Geschehen haben.

Diese Abhängigkeiten können im geschlossenen Kreislauf erkundet werden, was sich auf die Wechselseitigkeit von Körper (Interface) und Emotionen (audiovisuelle Reaktionen) gründet.

Bekannt ist die Richtung, dass Emotionen erlebt werden und sich daraufhin das Körperliche verändert, beispielsweise in der Gesichtsmuskulatur, die sich zu einem Lachen hin verzieht. Dies beschreibt beispielsweise Paul Ekman mit dem Facial Action Coding System. Andersherum zeigt die Kognitionswissenschaft im Forschungszweig Embodiment, dass Gefühle auch nach der körperlichen Regung erzeugt werden können. Ein bekanntest Beispiel hierzu ist der quer in den Mund genommene Bleistift, der zur Anspannung von Muskeln im Gesicht führt, die eigentlich zum Lächeln benutzt werden. Forschungen haben ergeben, dass ein solcher, emotional unbewusster, äußerer Einfluss zu deutlich positiveren Bewertungen von Situationen führt, als bei der neutralen Vergleichsgruppe.

©av@ar von Manfred Borsch, interaktive Installation mit Gestenerkennung

Generell steht in der Installation die Frage der Kontrolle, der Auswirkung, im Mittelpunkt. Was kann ich direkt kontrollieren? Wo erlebe ich Kontrollverlust? (zufällige Fehler zur Kontrollminderung sind vorhanden.) Und in wieweit werde ich kontrolliert/geleitet, also wonach richte ich mein Handeln aus. Diese durch die Überlagerung der Rezeptions- und Handlungsebene sehr individuelle Erfahrung kann zur Reflexion über eigene Handlungsziele führen. Beispielsweise kann ich erlernte Körperhaltungen wiederholen, um dem umherstehenden Publikum zu zeigen, dass ich Kontrolle ausübe, ich kann mich auf die Suche nach neuen Bildern und Tönen machen, ich kann die Synchronität der Bilder und der Musik in den Mittelpunkt stellen (VJing) oder mich zu der Musik bewegen, die ich durch meine Bewegung selber schaffe.

UD: Wie viele Reaktionen des medialen Ichs wurden vorproduziert?

MB: Es gibt 16 Einzelemotionen, die in vier Gruppen, den sogenannten Basisemotionen unterteilt sind. Mehr dazu unten… 🙂

Mit dem Überbegriff der Basisemotion versehen, werden die Emotionen wie folgt gruppiert:

Angst, Neid, Scham, Trauer: negative Emotion, passives Verhalten

Freude, Bewunderung, Stolz, Glück: positive Emotion, aktives Verhalten

Liebe, Mitleid, Dankbarkeit, Hoffnung: positive Emotion, passives Verhalten

Hass, Verachtung, Ärger, Verzweiflung: negative Emotion, aktives Verhalten.

©av@ar von Manfred Borsch, interaktive Installation mit Gestenerkennung

UD: Gibt es eine Relation zwischen den Einstellungsgrössen und den Besucheraktivitäten. Wann wird eine Detail oder Gross Einstellung genommen wann Halbtotale oder Totale?

MB: Es gibt eine mögliche Raum- und eine Körpererfahrung.

Der Raum kann in seiner Tiefe (Abstand der AkteurInnen zur Leinwand) erforscht werden, worauf sich die mediale Reflexion nach der Proxemik (E.T. Hall) in vier Stufen anpasst. Dies ist eingeteilt in die öffentliche Distanz (> 3m), gesellschaftlich-wirtschaftliche Distanz (1,5-3m), persönliche Distanz (0,5-1,5m) und die intime Distanz (< 0,5m) und wird so auch visuell Abgebildet (tief im Raum, als Spiegelsituation, Portraitdarstellung und Detailaufnahme. Je kleiner der Abstand, desto dezenter die dargestellte Emotion). Der Raum kann auch im Volumen erfahren werden, ausschlaggebend hierfür ist die durchschnittliche Höhe beider Hände. Hier können die vier Basisemotionen angesprochen werden. (Bsp.: Befinden sich beide Hände über der Kopfhöhe, wird die Basisemotion Angst angesprochen. Befindet sich der Akteur sehr nah vor der Leinwand, erscheint die Detailaufnahme – intime Distanz – des sich aufreißenden Auges). So ist der Raum mit vier Basisemtionen komplett abgedeckt.

Darüber hinaus können die weiteren 12 (Sekundär-)Emotionen durch bestimmte Körperhaltungen angetriggert werden. Hierbei muss erforscht werden, welche Körperhaltung zu welcher audiovisuellen Reaktion führt. (Bsp.: Beide Hände auf die Hüften gestützt, Oberkörper aufrecht -> Emotion Stolz). Auch diese Sekundäremotionen sind auf den vier verschiedenen Distanzebenen darstellbar, sodass es insgesamt (16×4) 64 vorproduzierte visuelle Reaktionen gibt.

©av@ar von Manfred Borsch, interaktive Installation mit Gestenerkennung

UD: Reagiert die Musik auch?

MB: Die Musik reagiert ebenso auf das Handeln der AkteurInnen, entzieht sich jedoch zum Teil durch Statistiken. Die Komposition unterteilt sich in vier Ebenen, die stets zusammen erklingen, und sich auf die vier deutschen Begriffe zur Emotion gründen. (Affekt, Gefühl, Emotion und Stimmung: je kürzer die Emotion, desto Objektbezogener. Ein Affekt (sehr kurz) ist somit sehr objektbezogen.) Die oberste musikalische Ebene (Affekt-Ebene) ist direkt an das Bild gekoppelt und kann zu jedem Zeitpunkt angespielt werden. Sie verton sehr genau alle 64 dargestellten Bilder. Die darunter liegende Gefühlsebene ist doppelt so lang (zwei Takte), berechnet sich aus dem Durchschnitt der zuvor angetriggerten Affekten und stellt die 16 Emotionen dar. Ebene drei (Emotionsebene) ist wiederum länger (vier Takte), wird aus dem Durchschnitt der angespielten Affekten berechnet und vertont die vier Emotionsgruppen (s.o.). Die längste Ebene (Stimmungsebene) unterscheidet nur noch zwischen positiv-annähernd und negativ-ablehnend (der emotionalen Grundtendenzen Neugeborener nach) und ergibt sich aus den Handlungen der letzten acht Takten (ca. 26 Sekunden).

Die musikalische Komposition (Tonart, Rhythmus, Melodie,..) bezieht sich hierbei auf die Affektenlehre des Barock, ein Regelwerk, dass sehr klare Vorgaben zur Vertonung von Emotionen vorsah, sich also sehr gut in den Grundcharakter der Installation einfügt, in der etwas sehr Menschliches wie Emotionen radikal in Gruppen einsortiert, systematisiert und damit abrufbar gemacht wird.

Ich bedanke mich für die inhaltsvollen und Erkenntnis unterstützenden Antworten!

©Matthias James Schuller

The Principlas sind die Produktioner, sie vertreten übrigens auch Paul Kalkbrenner, Lotus Lumina haben das Set und Pixel Mapping gemacht, die Inhalte kommen von der Pfadpfinderei.

Für „sunstrip“ haben sich sich zusammen getan. Und eigentlich sind alle 3 Gruppen erwähnenswert. Lotus-Lumina, in Erfurt angesiedelt, sind in der Medien und Licht Steuerung gut, aber wie gesagt, Set Design, Projection Mapping, 3D Visualisierungen und Inhalte erarbeiten sind ganz und gar nicht fremd.

sunstrip mad light from James / lotus-lumina.com on Vimeo.

Die Pfadfinderei machen motion design, konzipieren Events und das mit einem künstlerischen Anspruch. Wie alle von denen. Sie kommen aus Berlin, machen einiges in Clubs aber auch in Kulturstätten wie dem Radialwerk, die sich deutlich aus der Underground Szcene abgesetzt haben und eine modernen Hochkultur mit prägen. Sie haben sowohl Paul Kalkbrenner imPortfolio, haben die Live Tours auf die Bühne gebracht, aber auch MINI und Volvo gehören zu ihren Kunden.

©Matthias James Schuller

©Matthias James Schuller

©Matthias James Schuller

Mit Sunstrip haben sie ein scenografisches mappingprojekt realisiert. Es wird die Möglichkeit der Synchronisation von Lichtleisten und Video ausgetestet. Matthias James Schuller von lotus-lumina kontrolliert mit Hilfe von MadMapper und Module8, 63 Sunstrips Lichter und projizierte Visuals gleichzeitig, synchron. Das ist ziemlich smart.

©Matthias James Schuller

video von Matthias James Schuller auf vimeo eingestellt.

©ursula drees Beitrag von Ursula Drees