Category Archives: Inszenierung

©NYXVisual

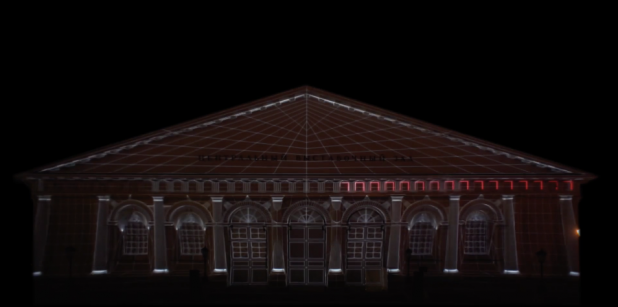

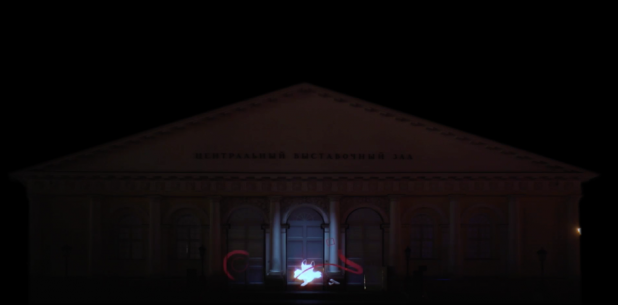

Louis de Castro vom Label NYX Visual hat mich schon einige Male auf neue Arbeiten aufmerksam gemacht. Und jedes Mal bin ich hoch erfreut. Das Label NYX Visual bleibt eine Gruppe hochkretativer und sehr ästhetisch arbeitender und denkender Gestalter. Die Musik ist immer ein besonders Hören wert. Die Bilder an der Fassade des Manjey, ein Gebäude aus dem 19 Jahrhundert ebenso. Sie schreiben selbst es handele sich um ein „very nice“ mapping Projekt. Und da Projektionsmapping nicht mehr die Sensation wie vor noch 5 Jahren ist, stimmt die Selbsteinschätzung.

©NYXVisual

Das Mapping befindet sich auf dem Weg zu stark dem Kommerz verschrieben zu werden, weg von den anfänglichen Kunstansätzen. Aber die Gestaltung und Visuellen Kräfte bleiben trotzdem. Jedes Gebäude bringt neue Herausforderungen, jede Umgebung ebenso. Es ist ein Werk in 3 Tile geteilt und in diesem Fall liessen sich die Künstler Benjamin Chassagne, Thomas Charier und Louis de Castro von russischer Architektur und Minimalismus inspirieren.

©NYXVisual

Louis de Castro

www.nyxvisual.com <http://www.nyxvisual.com/>

BALLERINA

——————

Circle of Light Festival 2013 (Moscow)

CREDITS

————–

Client : ART VISION

Diffusion : ETC RUSSIA

Concept : NYX VISUAL

Motion Design : NYX VISUAL (Benjamin Chassagne, Thomas Charrier, Louis de Castro)

Sound Design : Nicolas ZUBER (Featuring Babylone – Ballerina)

Beitrag von Ursula Drees

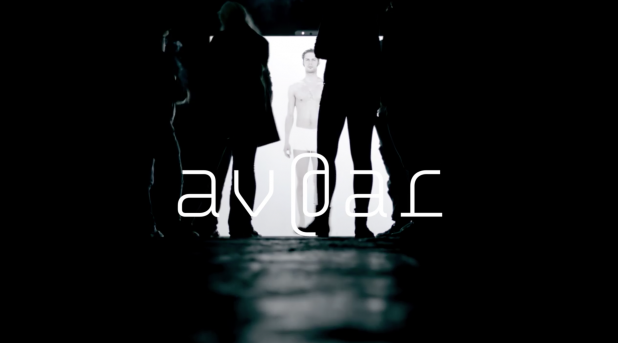

©av@ar von Manfred Borsch, interaktive Installation mit Gestenerkennung

Wir stellen die Diplomarbeit von Manfred Borsch, videograph, mit dem Titel „av@ar“ vor. Sie entstand am Institut Für Musik Und Medien. Herr Borsch hat nach der ersten Sicht freundlicherweise in einem online Interview Hintergrundfragen beantwortet. Mit diesem Wissen steigt der Genuss am Werk. es ist poetisch und hintergründig. Hintergründig weil die Interaktion sowohl aktiv als auch inhaltlich erarbeitet wird. Wer nicht genau hinschaut kann die Tiefe des Werks übersehen. Und das wäre schade.

UD: „Wie wird die Gestenerkennung gemacht? Haben sie Kinects eingesetzt? Wird Mimik abgenommen? Wenn ja, wie haben sie das technisch gelöst?“

MB: Die Gestenerkennung ist wie von Ihnen richtig vermutet mit einer Kinect, OpenNI mit NITE Middleware und der Programmierungsumgebung Max/MSP/Jiitter realisiert worden. Die Mimik wird nicht durch die Kamera aufgenommen, trägt jedoch thematisch zum geschlossenen Kreislauf der Installation bei.

Als Avatar wurde ein Mensch (und eben nicht eine digitale Form, wie beispielsweise eine Pixelansammlungen) gewählt, da durch Spiegelneuronen die Bindung zwischen BesucherIn und Abbild erhöht wird. Hierzu zählt auch das (teils unbewusste) Nachahmen von Emotionen mit der Gesichtsmuskulatur. Da alle Auswirkungen des Handelns in der Installation erforscht werden sollen, es also keine Spielanleitung o.ä. gibt, ist den InterakteurInnen zu Beginn nicht bekannt, ob sie auch mit ihrer Mimik einen Einfluss auf das Geschehen haben.

Diese Abhängigkeiten können im geschlossenen Kreislauf erkundet werden, was sich auf die Wechselseitigkeit von Körper (Interface) und Emotionen (audiovisuelle Reaktionen) gründet.

Bekannt ist die Richtung, dass Emotionen erlebt werden und sich daraufhin das Körperliche verändert, beispielsweise in der Gesichtsmuskulatur, die sich zu einem Lachen hin verzieht. Dies beschreibt beispielsweise Paul Ekman mit dem Facial Action Coding System. Andersherum zeigt die Kognitionswissenschaft im Forschungszweig Embodiment, dass Gefühle auch nach der körperlichen Regung erzeugt werden können. Ein bekanntest Beispiel hierzu ist der quer in den Mund genommene Bleistift, der zur Anspannung von Muskeln im Gesicht führt, die eigentlich zum Lächeln benutzt werden. Forschungen haben ergeben, dass ein solcher, emotional unbewusster, äußerer Einfluss zu deutlich positiveren Bewertungen von Situationen führt, als bei der neutralen Vergleichsgruppe.

©av@ar von Manfred Borsch, interaktive Installation mit Gestenerkennung

Generell steht in der Installation die Frage der Kontrolle, der Auswirkung, im Mittelpunkt. Was kann ich direkt kontrollieren? Wo erlebe ich Kontrollverlust? (zufällige Fehler zur Kontrollminderung sind vorhanden.) Und in wieweit werde ich kontrolliert/geleitet, also wonach richte ich mein Handeln aus. Diese durch die Überlagerung der Rezeptions- und Handlungsebene sehr individuelle Erfahrung kann zur Reflexion über eigene Handlungsziele führen. Beispielsweise kann ich erlernte Körperhaltungen wiederholen, um dem umherstehenden Publikum zu zeigen, dass ich Kontrolle ausübe, ich kann mich auf die Suche nach neuen Bildern und Tönen machen, ich kann die Synchronität der Bilder und der Musik in den Mittelpunkt stellen (VJing) oder mich zu der Musik bewegen, die ich durch meine Bewegung selber schaffe.

UD: Wie viele Reaktionen des medialen Ichs wurden vorproduziert?

MB: Es gibt 16 Einzelemotionen, die in vier Gruppen, den sogenannten Basisemotionen unterteilt sind. Mehr dazu unten… 🙂

Mit dem Überbegriff der Basisemotion versehen, werden die Emotionen wie folgt gruppiert:

Angst, Neid, Scham, Trauer: negative Emotion, passives Verhalten

Freude, Bewunderung, Stolz, Glück: positive Emotion, aktives Verhalten

Liebe, Mitleid, Dankbarkeit, Hoffnung: positive Emotion, passives Verhalten

Hass, Verachtung, Ärger, Verzweiflung: negative Emotion, aktives Verhalten.

©av@ar von Manfred Borsch, interaktive Installation mit Gestenerkennung

UD: Gibt es eine Relation zwischen den Einstellungsgrössen und den Besucheraktivitäten. Wann wird eine Detail oder Gross Einstellung genommen wann Halbtotale oder Totale?

MB: Es gibt eine mögliche Raum- und eine Körpererfahrung.

Der Raum kann in seiner Tiefe (Abstand der AkteurInnen zur Leinwand) erforscht werden, worauf sich die mediale Reflexion nach der Proxemik (E.T. Hall) in vier Stufen anpasst. Dies ist eingeteilt in die öffentliche Distanz (> 3m), gesellschaftlich-wirtschaftliche Distanz (1,5-3m), persönliche Distanz (0,5-1,5m) und die intime Distanz (< 0,5m) und wird so auch visuell Abgebildet (tief im Raum, als Spiegelsituation, Portraitdarstellung und Detailaufnahme. Je kleiner der Abstand, desto dezenter die dargestellte Emotion). Der Raum kann auch im Volumen erfahren werden, ausschlaggebend hierfür ist die durchschnittliche Höhe beider Hände. Hier können die vier Basisemotionen angesprochen werden. (Bsp.: Befinden sich beide Hände über der Kopfhöhe, wird die Basisemotion Angst angesprochen. Befindet sich der Akteur sehr nah vor der Leinwand, erscheint die Detailaufnahme – intime Distanz – des sich aufreißenden Auges). So ist der Raum mit vier Basisemtionen komplett abgedeckt.

Darüber hinaus können die weiteren 12 (Sekundär-)Emotionen durch bestimmte Körperhaltungen angetriggert werden. Hierbei muss erforscht werden, welche Körperhaltung zu welcher audiovisuellen Reaktion führt. (Bsp.: Beide Hände auf die Hüften gestützt, Oberkörper aufrecht -> Emotion Stolz). Auch diese Sekundäremotionen sind auf den vier verschiedenen Distanzebenen darstellbar, sodass es insgesamt (16×4) 64 vorproduzierte visuelle Reaktionen gibt.

©av@ar von Manfred Borsch, interaktive Installation mit Gestenerkennung

UD: Reagiert die Musik auch?

MB: Die Musik reagiert ebenso auf das Handeln der AkteurInnen, entzieht sich jedoch zum Teil durch Statistiken. Die Komposition unterteilt sich in vier Ebenen, die stets zusammen erklingen, und sich auf die vier deutschen Begriffe zur Emotion gründen. (Affekt, Gefühl, Emotion und Stimmung: je kürzer die Emotion, desto Objektbezogener. Ein Affekt (sehr kurz) ist somit sehr objektbezogen.) Die oberste musikalische Ebene (Affekt-Ebene) ist direkt an das Bild gekoppelt und kann zu jedem Zeitpunkt angespielt werden. Sie verton sehr genau alle 64 dargestellten Bilder. Die darunter liegende Gefühlsebene ist doppelt so lang (zwei Takte), berechnet sich aus dem Durchschnitt der zuvor angetriggerten Affekten und stellt die 16 Emotionen dar. Ebene drei (Emotionsebene) ist wiederum länger (vier Takte), wird aus dem Durchschnitt der angespielten Affekten berechnet und vertont die vier Emotionsgruppen (s.o.). Die längste Ebene (Stimmungsebene) unterscheidet nur noch zwischen positiv-annähernd und negativ-ablehnend (der emotionalen Grundtendenzen Neugeborener nach) und ergibt sich aus den Handlungen der letzten acht Takten (ca. 26 Sekunden).

Die musikalische Komposition (Tonart, Rhythmus, Melodie,..) bezieht sich hierbei auf die Affektenlehre des Barock, ein Regelwerk, dass sehr klare Vorgaben zur Vertonung von Emotionen vorsah, sich also sehr gut in den Grundcharakter der Installation einfügt, in der etwas sehr Menschliches wie Emotionen radikal in Gruppen einsortiert, systematisiert und damit abrufbar gemacht wird.

Ich bedanke mich für die inhaltsvollen und Erkenntnis unterstützenden Antworten!

©dezeen.com, dalson-house_leonardo-erlich

Das Dalson Haus in London von Leonardo Erlich. Menschen wandern auf der FAssade schwerelos herum. Sie sitzen, stehen auf dem Kopf, halten sich in den Armen, berühren sich an den Fingerfkuppen, rückwärts, vorwärts geradeaus. Wie machen das nur diese Leute. Keine braucht ein Sicherungsseil, alle sind vollständig unangestrengt, Spiderman is alive.

©dezeen.com, dalson-house_leonardo-erlich

Ein riesiger Spiegel reflektiert im Winkel von 45 Grad die auf dem Boden liegende Hausfassade, bzw. die Attrappe. Das Haus liegt in Hackney, ein klassisches Brickhouse in London. Wer jetzt über die liegende Fassade wandert ist schwerelos in der Reflektion. Ein spektakulärer Effekt. Natürlich geht das Spiel sofort los. Man kann so tun als würde man ganz besonders komplexe und schwierige Übungen an der Hausfassade vollbringen. Wer wollte nicht schon immer an einem Finger am Fenster hängen und dem Tod ausgeliefert sein?

©dezeen.com, dalson-house_leonardo-erlich

Die Fassade mit Fenstern und allem was dazu gehört sind wie ein klassischen Haus der Viktorianischen Zeit Ende des 19. Jahrhunderts in London gestaltet. Viele Häuser sehen so aus vor allem aber auch direkt in der Gegend um die Ashwin Street. Die Installation wurde von der Barbican Galerie in Auftrag gegeben und wurde am 25. Juni 2013 als Teil des London Festival of Architecture 2013 eröffnet. Es wird bis zum 4. August noch zu sehen bleiben.

©dezeen.com, dalson-house_leonardo-erlich

Der Künstler Leonardo Erlich arbeitet mit visuellen Täuschungen und Illusionen. Die Arbeiten sehen so einfach aus. Die Ideen sind leicht verständlich und deshalb noch besser. Kein Kopfzerbrechen, einfach erfreuen und geniessen. Die Einfachheit wird gerne unterschätzt. Erst mal muss die Fassade nachgebaut werden, sie muss ordentlich was aushalten, gross und schön sein, feuerfest sowieso, gegen alles gewappnet, der Spiegel muss her. Allein die Grösse ist nicht unkompliziert, der Transport, die Installation im richtigen Winkel und das ganze auch noch Unwetterfest, resistent gegen alles anzubringen ist kein Kinderspiel. Leonardo Erlich hat schon andere Werke mit ähnlich spannenden Illusionen geschaffen. Ein schwebendes Haus, ein im Schwimmbad schwimmendes Haus, ein toller, ziemlich unerwarteter Ausblick aus dem Flugzeugfenster und mehr.

©dezeen.com, dalson-house_leonardo-erlich

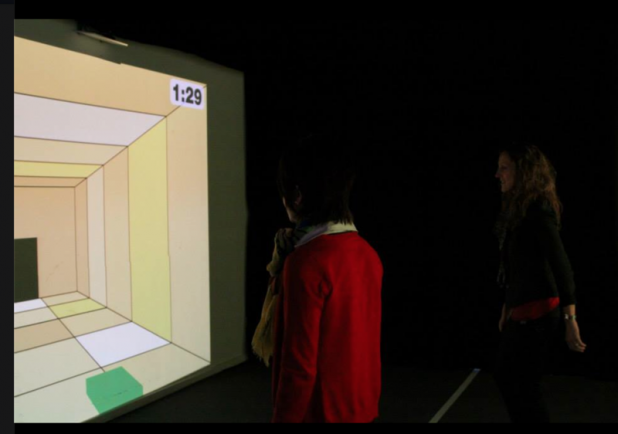

© creative application und Thomas Eberwein / Thomas Traum und Tim Gfrerer

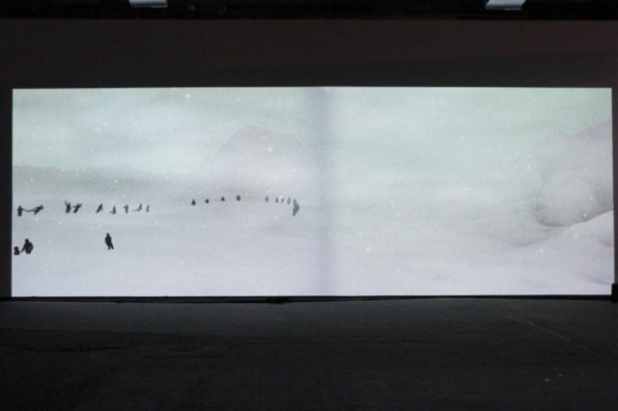

Gemacht wurde Ghost von Thomas Eberwein / Thomas Traum und Tim Gfrerer. In Ghost geht es um einen interaktiven Schneesturm, ein wüstes Naturereignis durch eine verlassene und karge Landschaft. Der Besucher findet sich in diesem Szenario wieder und muss sich retten. Wie kommt er heraus, ist er verloren und wird er den Kampf um Leben und Tod verlieren? Die Körper der vorherigen Besucher säumen seinen Weg und sein Bemühen. Ein unheimliches Umfeld.

Mehr unter http://thomastraum.com/#works/ghost/

© creative application und Thomas Eberwein / Thomas Traum und Tim Gfrerer

© creative application und Thomas Eberwein / Thomas Traum und Tim Gfrerer

Man sieht die Landschaft aus der Sicht eines überfliegendes Auges (Kamera), unterbrochen von einer Reihe vorproduzierter Stimmungen. Die Landschaft und die Stimmung beeinflussen die Intensität des Sturms, die Musik, die Farbe des Nebels und die Geräusche. Die Szenerie kann von intensiv, laut und aggressiv zu einem fast schon friedlichen, leisen Schneegestöber wechseln. Wird ein Besucher registriert, bewegt sich die Kamera auf ihn zu. Man sieht eine Reihe Naheinstellungen des Umfelds. Wenn niemand mit dem Werk interagiert, wechselt die Kamera auf Panoramaeinsteillungen, die auf ewig gefangene Geister der vorherigen Besucher zeigen.

© creative application und Thomas Eberwein / Thomas Traum und Tim Gfrerer

© creative application und Thomas Eberwein / Thomas Traum und Tim Gfrerer

© creative application und Thomas Eberwein / Thomas Traum und Tim Gfrerer

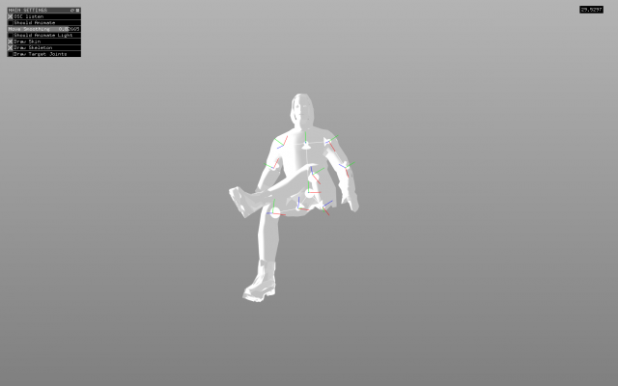

Die Installation wurde mit openFrameworks gemacht. Landschaft und Charaktere in einer 3D Modelling Software. Die über das menschliche Skelett abgeleiteten Bewegungen sind entworfen und neu programmiert. Besucherbewegungen werden ebenso von ihren Skeletten abgeleitet und mit der Open Source Software OpenNI framework aufgezeichnet. Die Daten werden mit OpenNI (Open Source Software) in die Hauptapplikation eingespeist. Dort findet das Einfügen der Bewegungen statt, und gleichzeitig eine Umwandlungen in Geister für spätere Verwendung in den leeren Landschaften. Die atmosphärischen Komponenten wie Farbe, Windgeschwindigkeit, Wolken, Nebel und Schneeintensität sind mit der Musik abgestimmt.

© creative application und Thomas Eberwein / Thomas Traum und Tim Gfrerer

© creative application und Thomas Eberwein / Thomas Traum und Tim Gfrerer

Spezielle GLSL shaders übernehmen die Charakter Animation. Sie werden in real time abgespielt und entwickelt um bis zu 100 Geister gleichzeitig animieren zu können. Gut 400 MB Skelettanimationen entstanden dabei. Sie werden in späteren Projekten und Einsätzen von Ghost verwendet.

Ghost entstand als Thomas Eberwein als Interactions Designer beim EPFL+ECAL Lab in Lausanne, Switzerland tätig war. Es ist eine Auftragsarbeit für die Ausstellung mit dem Titel “Give Me More” vom EPFL+ECAL Lab in der Eyebeam gallery in NYC im Frühjahr 2013. Die Musik kommt von Freefarm.

© creative application und Thomas Eberwein / Thomas Traum und Tim Gfrerer

http://www.creativeapplications.net

Autor von Creative Applications: Filip Visnjic

Beitrag in Deutsch von Ursula Drees

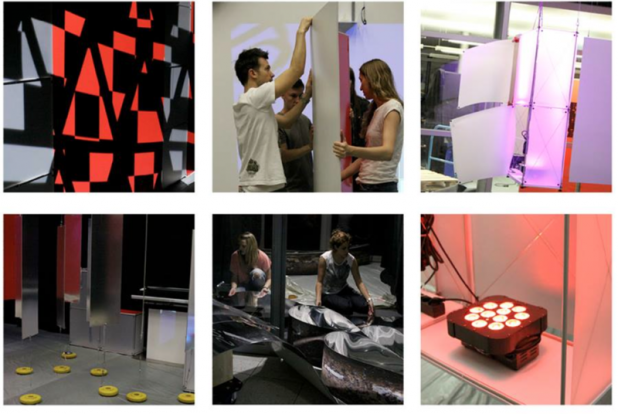

© Hochschule der Medien, Studioproduktion Event Media, Stuttgart

Idee_Hintergründige Überlegungen

Interaktivität nimmt Einzug in unser aller Leben. Nicht nur in der Freizeit oder im Beruf, sondern verstärkt auch in Lernumgebungen. Lernen findet auf unterschiedlichsten Ebenen statt. Wir gehen davon aus, dass Schulen, Hochschulen und Universitäten Spielumgebungen in die Lehre einbeziehen. Wir interessieren uns für das Thema Lernintensität und Erlebnisräume mit analogen und digitalen Schnittstellen.

© Hochschule der Medien, Studioproduktion Event Media, Stuttgart

Übergreifende Fragestellungen:

Welche Schnittstellen eignen sich für welche Lernkategorie (higher education und lower education)

Wie wird die innere Einbindung (Immersion) des Users durch Schnittstellen gesteuert?

Wie hoch ist der Erlebnisaspekt im Vergleich zum Erkenntniseffekt?

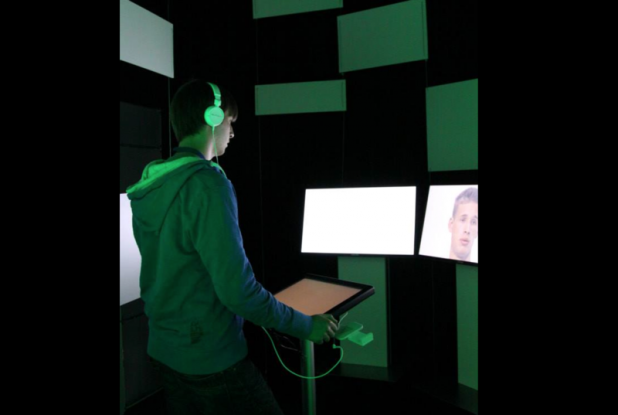

Diese drei grundlegenden Fragen motivierten die Konzeption und den Bau des interaktiven Erlebnisraums. In dem Erlebnisraum mit dem Namen INDI|VIRTUALITY werden fünf verschiedene Spiele mit unterschiedlichen Schnittstellen, Aktivitätsanforderungen und räumlichen Umgebungen vorgestellt.

© Hochschule der Medien, Studioproduktion Event Media, Stuttgart

Voraussetzungen_Grundlage eines jeden Spiels ist das sofortige Verständnis der Spielinhalte und die leichte Bedienbarkeit. Ein weiterer grundlegender Aspekt sind die unterschiedlichen architektonischen Spielumgebungen der zu untersuchenden Bereiche, sowie die jeweiligen Schnittstellen, mit der die Spiele gesteuert und bedient werden.

© Hochschule der Medien, Studioproduktion Event Media, Stuttgart

Der gestaltete Raum wird mit einer Time Lapse Kamera ausgestattet. Sie zeichnet die Bewegungen und Aktivitäten des Publikums auf. Das Publikum stellt einen Querschnitt der Bevölkerung dar. Die Ergebnisse werden ausgewertet und analysiert.

© Hochschule der Medien, Studioproduktion Event Media, Stuttgart

Inhalt der Installation_Die Idee nennt sich INDI|VIRTUALITY und lässt die Besucher als aktive Spieler ihr Ich erspielen. Der Besucher erspielt an verschiedenen Stationen seine persönlichen Eigenschaften. Die Spieler können sich durch geistige und körperliche Schnelligkeit beweisen. Mit Spaß, Lust und Freude formt jeder sein eigenes Profil. Die Einteilung des Spielverhaltens erfolgt nach dem Psychologiemodell „The Big 5“. Zunächst spielen die Besucher und werden anschließend in einen Ergebnisraum geleitet, in dem ihnen ihr Ergebnis an multimedialen Stationen präsentiert wird. Die Teilnehmer sehen, hören und erleben sich selbst und lernen ihre erweiterte Individualität kennen. Der Slogan für die Installation lautet deshalb: INDI|VIRTUALITY – Erspiele Dein Ich.

© Hochschule der Medien, Studioproduktion Event Media, Stuttgart

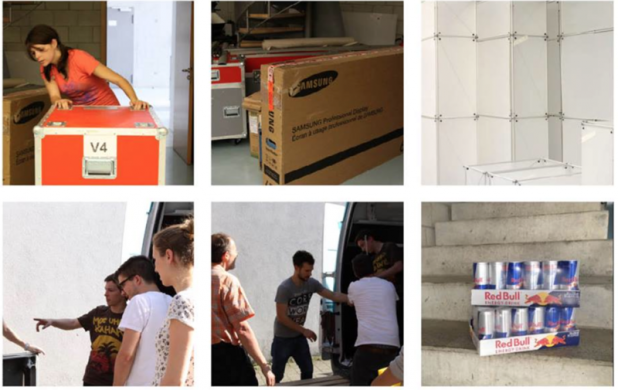

Verantwortliche Kreative_12 Studierende der Studiengänge Audiovisuelle Medien und Medienwirtschaft der Hochschule der Medien in Stuttgart realisieren in diesem interdisziplinären Projekt auf 120 qm einen interaktiven Erlebnisraum. Jeder einzelne Student bringt seinen Kompetenzbereich in das Projekt ein – Projektmanagement, Programmierung und Mediensteuerung, Konzeption, Szenografie, Grafik, Video, Ton, Licht und Bühne.

© Hochschule der Medien, Studioproduktion Event Media, Stuttgart

Gesellschaftlicher Nutzen_Durch die Einbeziehung digitaler Medien, Oberflächen, Schnittstellen, Bedienelementen und Raumaufteilungen verändern sich Lernumgebungen, Lernverständnis und Auffassungsgabe. Einerseits werden Überinformation, unüberschaubare Recherchequellen und ausufernde Wissensspeicher beklagt. Andererseits erkennt der Lernende die Möglichkeiten des kollaborativen, weltweiten, raum- und zeitunabhängigen Austauschs. Nicht jeder Benutzer jedoch macht positive Erfahrungen mit selbstgesteuerten, interaktiven Lernumgebungen. Man will herausfinden wie der Benutzer, also der Mensch, spielt, wann er spielt, wie begeistert er spielt, wie viel Körpereinsatz er zeigt, welche Schnittstellen er akzeptiert und bei welchen Schnittstellen er zögert. In dem spielerischen Interaktionsumfeld werden fünf Lernumgebungen entwickelt in denen die Affinität des Besuchers für die Aufgaben beobachtet wird. Unterscheidungen werden durch die äußere Erscheinung und Lernumgebung getroffen.

© Hochschule der Medien, Studioproduktion Event Media, Stuttgart

Äußerer Erscheinung und Lernumgebungen:

Die Lern- bzw. Spielumgebungen unterscheiden sich durch ihre Darstellung im Raum selbst (Größe, Einsehbarkeit, Ein- und Ausgang, Einbindung in den Gesamtraum).

Single Touch Table, bei dem das Eingabemedium mit dem Ausgabemedium übereinstimmt.

Single Touch Table, der als Eingabemedium dient. Dieses steuert Informationen auf drei Ausgabescreens, welche 1 Meter vom Eingabescreen entfernt sind.

Gestensteuerung durch zwei Kinect Kameras (Microsoft für die x-box Game Konsole). Der Besucher steuert Informationen durch körperlichen Einsatz.

Gestensteuerung durch eine modifizierte, der Spielumgebung angepassten WII Steuerung. Der Benutzer bedient ein stabähnliches Steuerobjekt.

Analoge Schnittstelle: Malen auf Leinwand mit Pinsel und Farbe

© Hochschule der Medien, Studioproduktion Event Media, Stuttgart

Funktion/Interface/Benutzerführung/Gebrauchswert_Funktion Benutzerführung

In Hinblick auf e-Learning Environments sind funktionale, selbsterklärende und damit userfreundliche Interfaces von besonderer Bedeutung. Unsere Interaktivitätsforschung im medialen Erlebnisraum untersucht aus diesem Grund verschiedene Interaktionsschnittstellen im Gefüge: Raum – User – (objektbasierte) Schnittstelle. Dabei untersuchen wir konkret die Fragestellungen

Warum soll mit Systemen kommuniziert werden?

Welche Bedingungen sind notwendig, damit der User mit Systemen kommuniziert?

Wie privat oder öffentlich kann ein Spielraum sein, damit der Bediener mit einem System interagiert?

© Hochschule der Medien, Studioproduktion Event Media, Stuttgart

Gebrauchswert_Die Entwicklung des Designs unseres Erlebnisraums verlief Hand in Hand mit der Konzeption der Benutzerführung.

Die modularen Bauelemente dienen einerseits als Designelement, andererseits übernehmen sie Funktionen wie die Wegeleitung durch farbliche, steuerbare Beleuchtung. Verschiedene Farben an den Stationen vereinfachen die Spielzuordnung und damit die Orientierung im Raum. Alle Objekte sind in der Grundfarbe weiß und bieten die Möglichkeit der Bespielung. Je nach Stationsanforderung dienen sie als Informationsquelle bzw. Projektionsleinwand. Mit Hilfe von Videomapping wird einerseits die räumliche Ästhetik erweitert, andererseits werden Anweisungen oder Previews eines Spielablaufs vermittelt.

© Hochschule der Medien, Studioproduktion Event Media, Stuttgart

Berücksichtigung von Nachhaltigkeitsaspekten_Produktionsaspekte

Wir berücksichtigen die Kosten, den leichten Auf-und Abbau, die Wiederverwertung der Elemente, die Einlagerung auf geringem Raum, sowie den Einsatz von ökologischen Produkten. Die Installation besteht zu weiten Teilen aus modularen Stecksystemen der Firma Burkhardt Leitner. Diese sind variabel in Größe, Menge, Darstellung im Raum und können zudem als Leuchtkörper verwendet werden. Sie lassen sich auf kleinsten Raum lagern, sind vielfältig einsetzbar und müssen nach dem Einsatz nicht entsorgt werden. Die Farben werden mit Licht gestaltet, welches an unterschiedlichste Raumgrößen und Ausstellungsflächen anpassbar ist. Fair Trade Produkte werden verwendet.

© Hochschule der Medien, Studioproduktion Event Media, Stuttgart

Benutzerführung und Interaktionsaspekte_Durch die Gegenüberstellung von analogen und digitalen Schnittstellen werden Einsatzkriterien für zukünftige raumübergreifende Erlebnis- und e-Learning Environments untersucht.

Technische Realisierbarkeit & Technisch-funktionale Innovation_Realisierbarkeit. Alle eingesetzten Techniken sind marktüblich, wenn auch auf die speziellen Anforderungen angepasst.

Eingesetzte Software:; Final Cut Pro (Bewegtbild), Premiere Pro CS6 (Bewegtbild), Eyeon Fusion (Bewegtbild), Mad Mapper 3.0 (Bewegtbild), After Effects (Bewegtbild), Adobe Photoshop (Grafik), Adobe Illustrator (Grafik), Adobe InDesign (Grafik), Abelton (Ton), Reason (Ton), Vector Works (Bühnenplanung), Java (Programmierung), C++ (Programmierung), Processing (Programmierung), Cinder (Programmierung), Madrix NEO (Lichtansteuerung)

© Hochschule der Medien, Studioproduktion Event Media, Stuttgart

Eingesetzte Hardware:, LED Wand, Single Touchdisplay, Touchdisplay, 40 Zoll, 16:9, Flachbildschirme, 35 Zoll, 16:9, Full HD LCD Bildschirme, 65 Zoll, 16:9, Wii-Remote-Controller, Kinect Kamera, 5 Sound Tube Soundduschen, American DJ Flat Par QA12X, American DJ 4 Stagepack, Mobilight, Ape Labs, Edirol Audio Interface, Genelec Boxen

© Hochschule der Medien, Studioproduktion Event Media, Stuttgart

Innovation_Innovationen finden in folgenden Bereichen statt:

Ummantelung der WII Schnittstelle zur Übereinstimmung mit der Grafik sowie dem Look and Feel und dem Bewegungsablauf. Erweiterung des Spielfelds bei der Gestenerkennung. Nicht nur auf einer scharf umrissenen horizontalen Ebene kann der Besucher agieren, ein Vor- und Zurücktreten ist möglich. Die Kamera erkennt weiterhin die Bewegungen und ordnet sie korrekt ein.

© Hochschule der Medien, Studioproduktion Event Media, Stuttgart

Wirtschaftliche Verwertbarkeit_Das in dieser interaktiven Rauminstallation geschaffene Testszenario darf als Prototyp für die verschiedenen Spiel-Environments verstanden werden. Diese können auf Präsentationen, Messen, Roadshows und anderen event-medialen Einsatzszenarien wie Oper, Schauspiel, Konzert verwendet werden. Sie lassen sich mit verschiedenen Inhalten in entsprechende Environments einbinden.

© Hochschule der Medien, Studioproduktion Event Media, Stuttgart