Category Archives: Gestensteuerung

HdM-Studenten inszenieren den Stuttgarter Hafen

Am 25. März 2017 ab 19 Uhr stellen Studenten der Hochschule der Medien (HdM) in Kooperation mit dem Hafen Stuttgart bei der „Langen Nacht der Museen“ ihr Projekt „Grenzgebiete“ vor. In sieben Installationen loten sie die Grenzen zwischen Land und Wasser aus. Die HdM-Studenten schaffen optische Illusionen und irrationale Wahrnehmungen. Licht- und Klangobjekte, interaktive Installationen und Projektionen an Gebäude- oder Wasserwänden erweitern den Raum des Vorstellbaren im Hafen.

Der Neckar verbindet Stuttgart und die Region mit dem Rest der Welt. Der Hafen inspiriert als Grenzgebiet mit seiner, urbanen, industriellen Atmosphäre immer wieder Künstler. So auch die HdM-Studenten aus dem Studiengang Audiovisuelle Medien und Medienwirtschaft. Sie beschäftigen sich in der „Studioproduktion Event Media“ unter der Leitung von Prof. Ursula Drees und Steffen Mühlhöfer mit der Inszenierung von interaktiven Erlebnisräumen. Das ist diesmal der Hafen, als Grenzgebiet für Wasser und Land, Stadt und Landkreis, Bewegung und Stillstand, Verortung und Übergang. Diese Themen inszenieren die Studenten in sieben Installationen, in denen sie Grenzen verschieben.

Grenzlichter, Grenzübergänge, Grenzverschiebungen und Grenzfälle

Im überdachten Boarding-Bereich wird den Besuchern, die auf die Abfahrt der Passagierschiffe warten, ab 20.30 Uhr zur vollen und zur halben Stunde eine interaktive Projektion am Containerterminal geboten: Tänzerinnen setzen mit ihren Bewegungen neue Grenzen. An einer weiteren Station, „Grenzlichter“, schaffen die Besucher eine tonale Hafenkulisse durch die Berührung von Lichtstäben in einem Kubus. Die Fahrt unter der Otto-Konz-Brücke hindurch wird zu einem Licht- und Tonerlebnis: „Grenzübergang“ inszeniert mit emotionalen Licht- und Tonstimmungen im Inneren des Bootes die Durchfahrt durch einen Lichtbogen, nämlich der Brücke. An der Station „Grenzgewässer“ werden auf eine Wasserwand optische Illusionen der Unendlichkeit projiziert. Die Station „Grenzverschiebung“ ist ein Fassadenvideo-Mapping und zeigt das Innenleben, die sinnliche Wahrnehmung des Bauwerks. Die Station „Tiefengrenze“ stellt die Unterwasserwelt vor, projiziert direkt auf das Wasser. Eine weitere Station, eine Fassadenprojektion namens „Grenzfall“, hebt die Grenzen der Schwerkraft auf.

Abfahrt alle 30 Minunten

Die Schiffe legen ab 19 Uhr etwa alle 30 Minuten zu der insgesamt 20-minütigen Hafenrundfahrt ab. Gäste sind herzlich zum Besuch im Hafen eingeladen. Im Boarding-Bereich werden Getränke und ein kleiner Imbiss angeboten. Tickets für die „Lange Nacht der Museen“ gibt es online (https://www.lange-nacht.de/veranstaltungen/tickets-online/), bei den Vorverkaufsstellen (https://www.lange-nacht.de/vorverkaufsstellen/) oder an der Abendkasse.

Die Lange Nacht der Museen ist in Stuttgart ein Begriff.

Unter vielen anderen Begebenheiten und Attraktionen wird der Stuttgarter Hafen am Neckar für das Publikum zugängig und bepielt. In diesem Jahr wird die Hochschule der Medien, der Studiengang Audio Visuelle Medien und insbesondere 11 Studierende der Studioproduktion Event Media die Bespielung übernehmen.

Es sind verschiedene Installationen geplant, eine davon ist die Installation namens Grenzkörper. Diese Installaiton wird im Wartebereich vor dem Einstieg auf ein Schiff zu sehen sein. Dort sammeln sich die Besucher. Sie wollen nicht nur durch speise und Trank unterhalten werden, sondern natürlich auch durch kunstvolle Installationen und Bespielungen.

Deshalb wird beim Sammelbereich eine 3 x 6 große Bühne aufgebaut. Bühne ist vielleicht ein zu großer Ausdruck, ein Sockel. Darauf werden nicht nur Tänzerinnen halbstündig die Installation demonstrieren, es werden natürlich auch Besucher eingeladen, den Schritt auf den Sockel zu wagen und durch Bewegungen eine Projektion auf der anderen Seite des Hafenbeckens auf die Container zu verändern. Die Projektion zeigt abstrahierte Wasserpolygone. In diesen befinden sich Lichtpartikel. Sie strömen durch dieses Wasser. Tritt ein Besucher auf den Sockel werden Bewegung und Silhouette erkannt (Kinect v2 Kameras) und beeinflussen die Wasserbewegungen auf der Projektionsseite. Außerdem werden innerhalb des Projektionsraums weitere durch geometrische Figuren gekennzeichnet Bereiche sichtbar. Diese Bereiche sind mit Tönen verbunden. Wer sich bewegt verändert die Wasserströmung und komponiert gleichzeitig. Er sollte sich also wirklich bewegen.

![]()

Angefangen hat es mit visuellen Tests. Wie sieht das Wasser aus? Welchen Abstraktionsgrad wird es aufweisen? Wird die Strecke von 80 Metern von den Projektoren gut abgebildet. Weiviele Kontraste werden eingeplante. Wie ist die Farbsättigung? Wie werden die Projektionsbilder auf den farbigen Containern zu sehen sein? Einige Fragen sind bereits beantwortet, andere werden vor Ort bei den jeweiligen Tests angepasst.

Dann ging es um das Strömungsverhalten. Werden die Besucher überhaupt erkennen, dass sie etwas verändern und bewegen? Wie schnell muss sich was bewegen?

Und die Frage natürlich nach der Erkennbarkeit der Musikcluster im Raum.

Auf der Media Night an der Hochschule der Medien wurde Ende Januar ein Prototyp dem Publikum vorgestellt. Es war ein Testfall. Denn bis dato waren keine Usabilitytests mit Publikum gemacht worden. Die Fragen ob und wie sich Fremde in diesem Bereich verhalten waren offen. Mit einer Erklärgrafik oder wohl eher Poster wurde begonnen in der Hoffnung, dass die Leute dieses Plakat sehen, lesen und verstehen.

Die ersten Besucher kamen, sie wurden geleitet und verbal eingeführt und dann zeigte sich dass die Menschen sehr verhalten Bewegungen im öffentlichen Raum nachgehen. Sie standen vor der Projektion und schauten. Es wurde gezeigt was sich tut. Dann konnte es sein, dass der ein oder andere vielleicht die Hand anhob. Diese Zurückhaltung war unerwartet. Denn so konnten sie die Töne im Raum nicht finden und nicht erklingen lassen. Ein großer Teil der Installation schien verloren.

Deshalb wurde das tonale Feedback, nämlich das Erklingen des Tons, durch ein grafisches erweitert. Ein geometrisches Feld zeigte bei der Bewegung, an, dass sich an diesem Ort Etwas versteckt. Mit der visuellen Kennzeichnung fiel es den Besuchern ein wenig leichter Ihre Möglichkeiten mit dem System abzuschätzen und vielleicht in den Spielmodus zu kommen. Das visuelle Feedback stellt den Bezgu zwischen dem handeln und dem Hören dar. Erst dann erschien es deutlich.

Außerdem wurde die Soundspur den Besuchermöglichkeiten angepasst. In der vorlaufenden Testläufen spielt ein Background-Loop einen bestimmen Soundteppich ab. Das wurde gemacht um eine Stimmung zu erzeugen. Mit der Bewegung wurden Soundspuren diesem Loop zugefügt. Die Musik sollte sich verdichten und kompakter werden. Diese hinzugefügten Sounds wurden deshalb auch langsam eingefadet. DAs wiederum führte zu Erkennungsunklarheiten. Gehört dieser Soundcluster zum Defaultteppich oder habe ich das ausgelöst?

Deshalb wurden neue sehr kurze Töne auslösbar. Sie kommen sofort und ohne fade in. Sie sind an die Grafik gebunden, das visuelle Feedback. Dadurch wurde die Verständlichkeit für die Besucher erhöht.

Dennoch stehen Künstler vor der Problematik des musealen Verhaltens. Denn Besucher haben gelernt nichts zu berühren und zu verändern. Moderne interaktive Installationskunst ist jedoch genau darauf aufgebaut. Wer nichts tut erschließt das Werk nicht. Dann bleibt es verborgen. Das Ende ist noch nicht erreicht.

alle Photographien © Hochschule der Medien Studioproduktion EventMedia 2017

Das Thema ist bedrückend. Die Pharmaindustrie verwendet immer noch Tiere für Versuche ihrer Neuentwicklungen. Es ist Tierquälerei: schauderhaft. Wir kaufen die Produkte nichtsahnend welch Schmerz, Qual und wieviel Tod damit einher gingen. Diese Installation schärft das Bewusstsein.

Ein Plattenteller steht vor der Projektionsfläche. Dort laufen im Loop Werbefilme von Produkten und Herstellern, die Tierversuche verwenden. Wenn dann der Plattenteller wie beim DJ hin und her geschoben wird, wenn wir scratchen, dann mischen sich Bilder der Versuche selbst in den Videofilm. Mal sehen wir in Panik kreischende Äffchen, dann in winzigen Käfigen eingeschlossene immer im Kreis sich drehende, verzweifelte Beagle, oder halbaufgeschnittene, noch lebende Mäuse und andere Kleintiere. Es ist ein schauderhaftes Geschäft.

Karol Kensy Student der Kunstuniversität in Linz, Fachbereich „Zeitbasierte und Interaktive Medien“ hat viel Zeit in die Hintergrundrecherche gelegt. Denn die Pharma-, Waschmittel- oder Kosmetikhersteller wollen nicht mit ihren Machenschaften in Verbindung gebracht werden. Nachweisbarkeit und Informationsgenauigkeit spielen eine Rolle. Diese Installation hat politische und gesellschaftliche Relevanz.

http://www.aec.at/aeblog/de/2016/06/10/scratching-wounds/

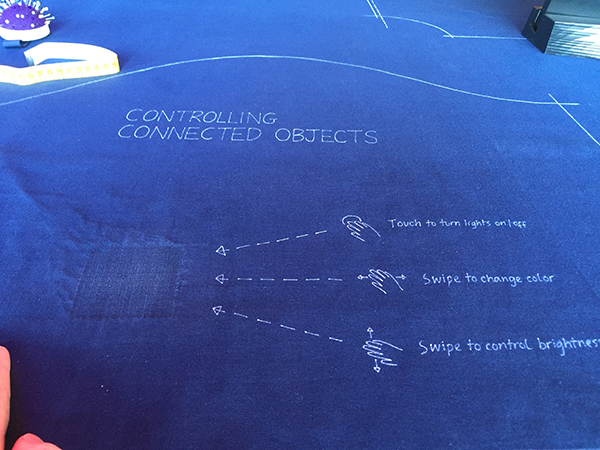

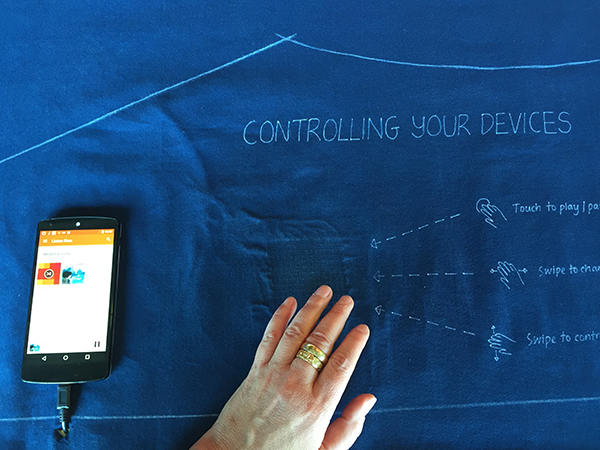

Ein Stück Stoff in das leitfähige Garne eingenäht sind. Es sind dünne, metallische Legierungen, kombiniert mit natürlichen und synthetischen Materialien wie Baumwolle, Polyester oder Seide. Und damit werden sie zu Interaktionsschnittstellen.

“If you can weave the sensor into the textile, as a material,” so Poupyrev, “you’re moving away from the electronics. You’re making the basic materials of the world around us interactive.” Wenn der Sensor in das textile Gewebe eingefügt werden kann dann bewegen wir uns weg von Electronic. Die Grundlagenelemente unserer Welt werden interaktiv. Wir brauchen keine weiteren Geräte oder Devices. Diese idee ist nicht besonders neu. seit gut einem Jahrzehnt wenn nicht länger wird von intelligenten Stoffen geredet und daran experimentiert. Was aber neu ist, wenn die Gewebe in normalen Textilfabriken hergestellt werden. Wenn es nicht mehr Einzelstücke sind, sondern das Gewebe Teil der Konsumwelt wird.

“Any time you put your phone into your pocket, you have a smart jacket… the only problem is they don’t talk to each other. There’s no connection between them. So this work, we can actually kind of close the circuit.”

Jedes Mal wenn wir unser Handy in die Jackentasche stecken dann haben wir intelligente Kleidung. Nur in diesem Fall ist der Device vollständig abgeschirmt und die Kleidung auch. Warum werden sie nicht miteinander verbunden?

Das Gewebes Stoff und die Garne sind dünn. Sie sind biegsam, sie fühlen sich wie Garn an. Das ist vertrauenserweckend. Die interaktive Stelle erscheint vielleicht wie ein kunstgestopftes Teil, aber nicht störend. Mit Wischbewegungen wird vielleicht Music auf dem Cellphone gewechselt, das Volumen rauf oder runter gesteuert, oder ein und aus geschaltet. Mit anderen Verbindungen werden LED Lampen gesteuert. Ein und aus, hoch oder runter dimmen, Farbtemperaturwechsel. Es gibt eine Vielzahl von Geräten, die diese drei Funktionsweisen in sich tragen, sie können mit den Schnittstellen verbunden werden. Das Ganze ist einfach und weiter fortgeschritten als andere interaktive Textilien.

Wie das mit dem Waschen und Pflegen ist, das wird nicht gesagt.

Was ist weiter entfernt vom bürgerlichen Leben: Der Mond oder das Leben eines Häftlings in US Gefängnissen? Und nicht irgendein Häftlingsleben, sondern jener in Einzelhaft? Kaum zu beantworten diese Fragen. Beide Leben oder Zustände sind unendlich entfernt. Interessiert uns das Leben eines Häftlings in Einzelhaft? Interessiert uns der Mars? Der wohl eher, daran sind Visionen und SciFi geknüpft. Ein Häftling ist kaum noch Mensch, eine Nummer, eine unbekannte Person. Der hat etwas Schlimmes getan, hat vielleicht getötet also hat er kein Recht auf Menschlichkeit, oder?

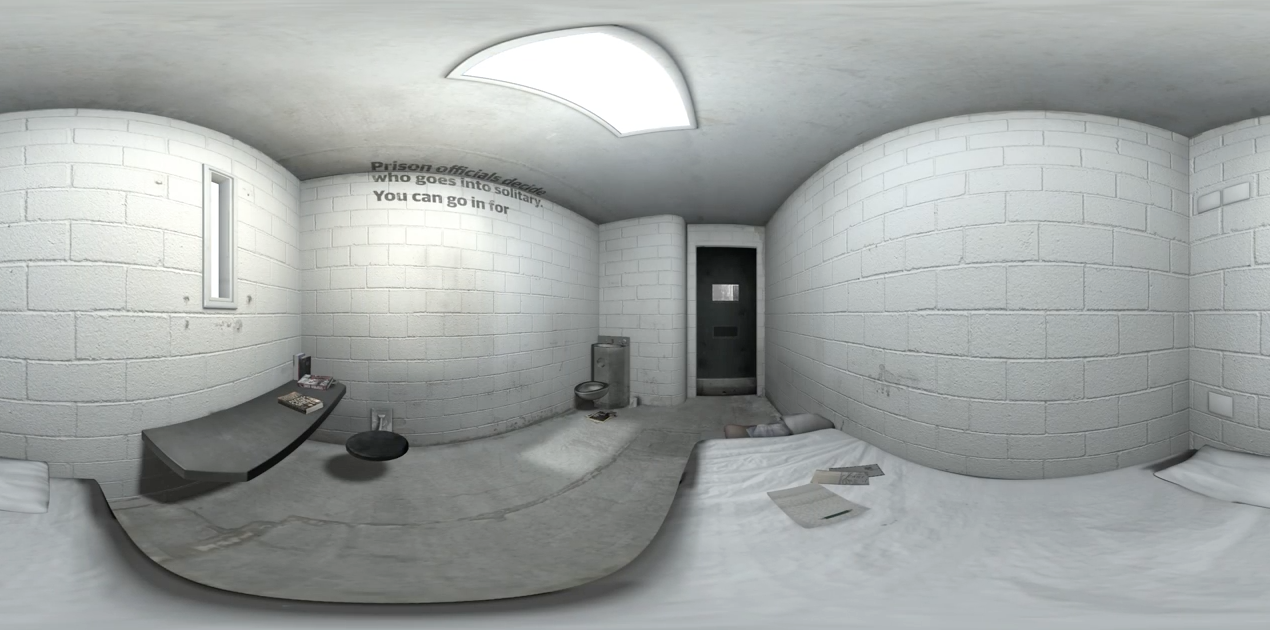

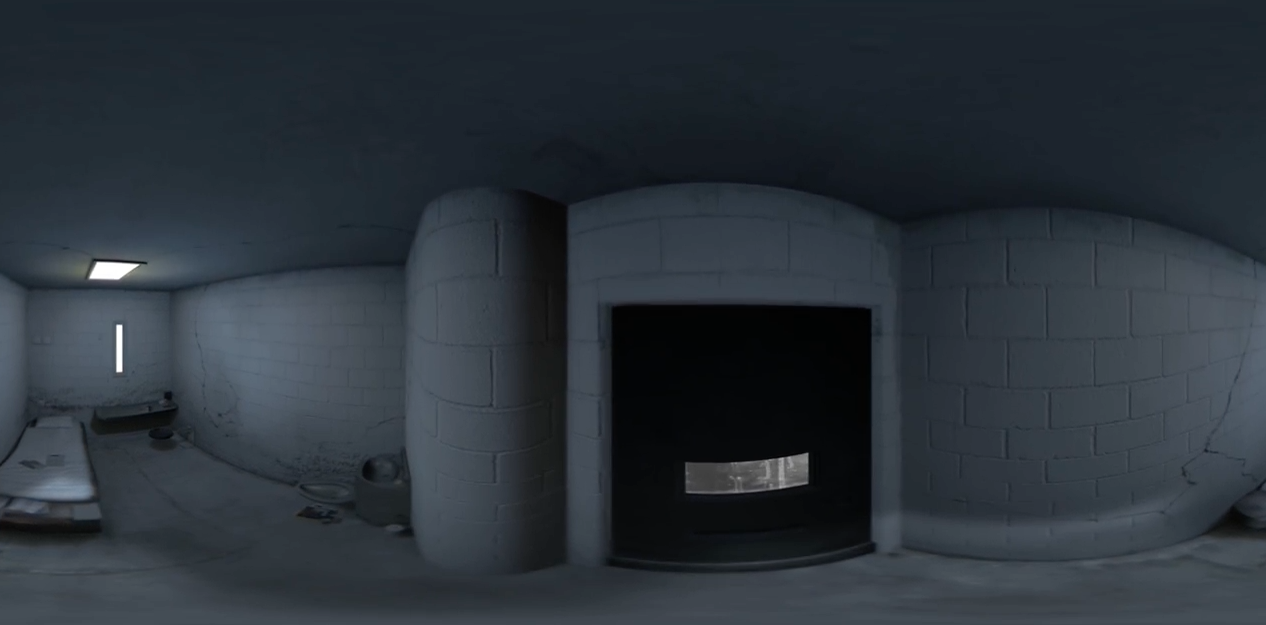

Ed Thomas von the Mill, London lassen mit dem Game 6×9:solitary confinement in 360 Grad das Leben, das Dasein der US Amerikanischen Häftlinge in Einzelhaft nachvollziehbar auferstehen. Es ist eine VR immersive Geschichte um einen Tag in Einzelhaft. Wie kann Empathie aufgebaut werden? Von so entfernten Lebenswelten?

Der Blick in eine übertriebene Fantasiewelt vielleicht? Geschichten von Angehörigen, von Wärtern, von Opfern? Oder der Blick des Häftlings. Die „One Person Story?“ Es heisst authentisch zu sein, ernsthaft und „faithfully“.

Es ist der Versuch ein Dokumentarisches VR Game zu präsentieren. Es soll echt wirken, real. Der Spieler ist in einer Zelle: 6 x 9. einer wirklichen Zelle nachempfunden, vielleicht sogar mehr. Nicht erdacht, sondern dokumentarisch nachgebaut. Eine Metazelle, eine die für alle Zellen gilt. Als real time environment ist das gut, denn eine Zelle ist vom Raum überschaubar, Detailreichtum kann erzielt werden. Und das macht die Zelle lebendig. So ein Umfeld ist beängstigend. „Creepy“ und der Sound ist es ebenso. Es ist echter Sound. Wirkliche Stimmen, wirkliche Geräuschkulissen. Es gibt Voice overs von Insassen. Sie erzählen von sich, von Phantasien, Gedanken von Erinnerungen, reflektieren, denken laut. Diese Voice overs basieren auf Gesprächen mit den Häftlingen. Die Stimmen passen. Die Lautstärke, der Raum. Es ist ein real time environment. Der Spieler begibt sich 9 Minuten in die Schuhe eines Häftlings. Er soll körperlich erleben was die Häftlinge fühlen. Es ist der Kontrollverlust, es ist der Wunsch zu überleben in dieser Isolation. Mit immer gleichen Wänden, mit einer spartanischen Einrichtung. Einer Matratze, die tagsüber aufgerollt wird. Mit eingeschränkten Lebensrechten. Mit vielen Verboten und Geboten: „roll die Matratze auf, putze, esse, schlafe wenn das Licht aus geht“.

Anfangs dürfen die Spieler nichts. Erst langsam lockert sich die Schärfe und Interaktion wird zugelassen. Sie dürfen einen Brief schreiben, “ letter writing excercises“ hört sich stärker an. Die Spieler erlebt den Verfall des Ichs, „psychological detoriation of the inmate“.

Anfangs dürfen die Spieler nichts. Erst langsam lockert sich die Schärfe und Interaktion wird zugelassen. Sie dürfen einen Brief schreiben, “ letter writing excercises“ hört sich stärker an. Die Spieler erlebt den Verfall des Ichs, „psychological detoriation of the inmate“.

Wie kommt es zu so einer Idee? Denn VR wird oft für irrelevante Umgebungen eingesetzt. natürlich geht es immer um Immersion, um das Eintauchen in eine fremde Welt, um ein körperliches Empfinden, nicht die passive Vorstellung mit Empathie angereichert, sondern das in die Rolle eintauchen. „Mache einen Fallschirmsprung, fliege wie ein Vogel, gehe als Zwerg durch eine Welt.“ Aber „Lebe das Leben eines Outcasts?“ Dokumentarische Themen sind stark, sie sind da, sie sind Leben. Auch ein Leben das der Normalmensch nicht ansatzweise versteht. Jetzt wird VR klug. Wie lebt ein Flüchtling, wie lebt es sich als Expat im Ausland, wie lebt man in Johannesburg oder in anderen lebensbedrohlichen Umgebungen?

Ed Thomas erzählt, dass die Tester durch ihre Körpersprache den Spielzeitpunkt anzeigten. Wie eingeschränkt, wie bewegungsbeschnitten sie waren. Wie sie sich drehten und dann nicht mehr. „Tester had a specific body language. We knew where they were by examining the body language“.

Anfangs dachten die Kreativen von THE MILL, 9 Minuten seinen zu lang. Aber nein, die Zeit vergeht schnell. Es ist ein 6×9 VR Experience.

Fotos: entweder Screenshots vom Trailer auf You Tube oder mit freundlicher Genehmigung der Organisatoren der FMX.