Monthly Archives: März 2019

Eine gedruckte Stahlbrücke im Zentrum von Amsterdam, die 3D Printing Technologien auf höchsten Niveau präsentiert.

Das Forschungsprojekt begann als Laborexperiment im Jahr 2011. Zu der Zeit stand der 3D Druck in Kinderschuhen, wenngleich auch der Erfolg dieser neuen Technologie absehbar war. Dennoch wurden eher kleinere Objekte im 3 D Druck realisiert. Eine Brücke aus Stahl zu drucken darf als Idee, als Vision verstanden werden, aber ob es zu einer erfolgreichen Technologie führen würde, wusste keiner.

Tim Geurtjens, CTO MX3D auf der Website: „Wir versuchen außerhalb der Regel zu denken. Wir wollen experimental sein. Wir wollen nicht mit den bis dahin bekannten Begrenzungen des 3-D Drucks umgehen. Eine funktionstüchtige lebensgroße Stahlbrücke zu drucken, demonstriert die unendlichen Möglichkeiten des 3-D Drucks. Dieses „Nach Vorne“ Denken unterscheidet uns von den anderen.“

Das multidisziplinäre Team namens MX3D entwickelte sich aus dem harten Kern der ursprünglichen Forschergruppe. Zusammen mit Joris Laarman, der sich für das Design einer solchen Brücke verantwortlich zeigt, mit dem gleichnamigen Joris Laarman Lab bildeten sie eine kreative Tech-Community. Joris Laermann selbst dazu: „Ich glaube intensiv an die Zukunft der digitalen Produktion, sie manifestiert eine neue Handwerkskunst.“

Das Unterfangen sollte als Proof of Concept verstanden werden. Die Kapazität des 3D Drucks sollte neu definiert und demonstriert werden. Die Grenzen des klassischen Bauvolumens sollten überschritten werden. Kann ein großformatiges, architektonisches Objekt hergestellt werden? Geht es ohne Stützstrukturen? Welche Materialien eigenen sich, welche Roboter und Drucker sind passend? In mehreren Einzelteilen und Durchgängen zeigte sich, dass es möglich ist, Elemente mit Massen wie 2 x 4 x 1,5 Meter zu drucken.

2018 wurde die 3-D gedruckte Edelstahlfußgängerbrücke realisiert und in Amsterdam fest installiert. Mit der Inbetriebnahme wird weiter geforscht. Mit Hilfe eines digitalen Zwillings werden Strukturverhalten und Bewegungen der Brücke untersucht. Dafür wurden Sensorsysteme in die Brücke verbaut und helfen zukünftig, eine der 3 D Druckverfahren geeigneten Ästhetik zu entwickeln. Das Projekt heißt MX3D und wird durch drei industrielle Multiachsenroboter, entsprechenden 3D Tools und Software hergestellt.

Die Gruppe befindet sich in ständiger Bewegung: recherchiert, entwickelt und verbessert ihre Technologien mit ihren Partnern, um nicht nur im Hard- und Softwarebereich, sondern auch bei Konstruktionen und Materialdruck, Neues zu schaffen. Künstler, Ingenieure, Handwerker und Softwareexperten arbeiten zusammen und forschen an digitalen Technologien, Robotik und traditionellen industriellen Produktionsbestimmungen und -möglichkeiten.

Techniken:

Standard Robot +

Standard Welding Machine +

MX3D’s proprietary software

Speed: 1-3 KG per hour per nozzle

Ausgezeichnet mit dem STARTS Prize, gesehen auf der Ars Electronica 2018. Die europäische Kommission hat die Starts Initiative ins Leben gerufen, um die Einbindung der Künste in innovative Projekte zu unterstützen. Starts möchte die kreativen Kräfte einer interdisziplinären Zusammenarbeit der Künste mit den Technologie nutzen, um neuwertige, experimentelle und kreative Prozesse in und für Europa zu unterstützen. Entwicklung, Erfindung, kritische Blickpunkte und Technologien zu entwickeln, bedeutet, zu hinterfragen.

Wofür nun steht Starts? S + T für Science und Technologie, Arts für die Künste: macht zusammen Starts. Europa fußt auf Innovation, um auf der globalen Ebene und in unserer Gesellschaft bestehen zu können. Es geht um einen Mehrwert für Bürger und Arbeit. Es ist ein holistischer Ansatz, der die Starts Initiative treibt.Starts unterstützt Kollaborationen zwischen Künstlern, Wissenschaftlern, Ingenieuren und Forschern, die kreative, einbindende und nachhaltige Technologien entwickeln möchten. Ein zweites Ziel der Starts Initiative ist die Erkenntnis, daß Künstler durch ihr kritisches Denken neue Möglichkeiten eines Einsatzes für Technologien anstoßen können. Und diese Fähigkeit soll genutzt werden, damit Technologien schneller in unsere Gesellschaft eingeführt werden.

Starts besteht aus vier Säulen. Einmal gibt es den Staatspreis der mit 20.000€ hoch dotiert wird.

Beitrag von Ursula Drees

Mehr dazu hier (MX3D)und hier (Boris Haarmann Lab).

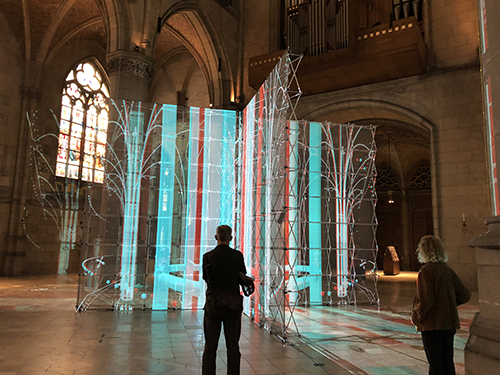

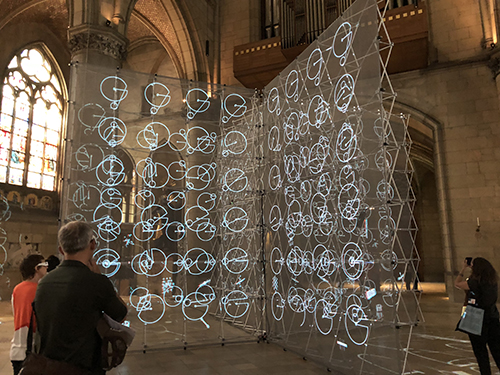

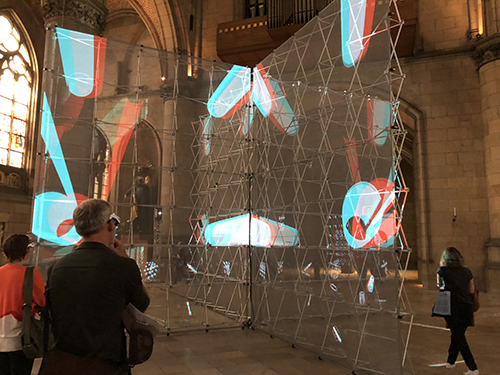

Light Tank von Uwe Rieger und Yonan Liu. Der Mariendom in Linz eignet sich hervorragend für großräumige Installationen. Es ist ein imposantes Gebäude. Von außen, als auch von Innen, wie jeder Dom. Die Höhe, die Breite, das Gestein und die Akustik sind beeindruckend, auch ohne Installation. Light Tank ist wie alle, von Uwe Rieger geschaffenen Installationen, auf den Raum ausgerichtet. Sie ist luftig, verfügt über eine faszinierende akustische Stimmung und ist von allen Seiten zu betrachten.

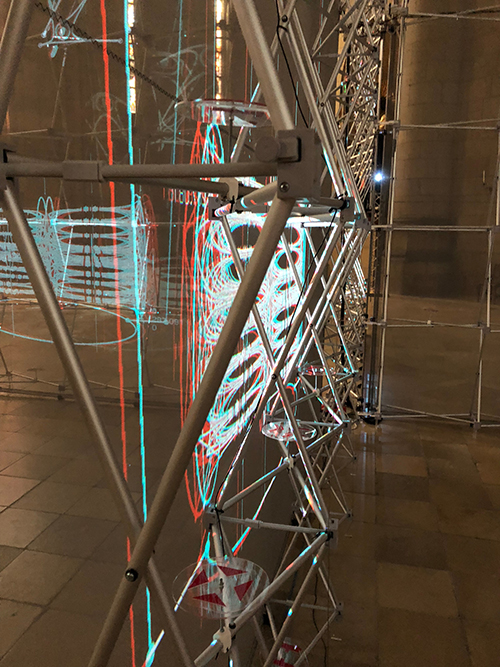

Light Tank ist eine Mixed Reality Installation. Es werden holographische Linien auf eine transparente Gerüststruktur projiziert. Diese Gerüste sind mit durchsichtigem Meshgewebe bezogen. Und wenn die Lichtlinien auf dieses Meshgewebe fallen, begreifen die Besucher, das es eine Projektionsfläche ist. Ohne Lichtprojektion erkennt man den skeletthaften Aufbau und schaut hindurch. Das Gerüst ist vielleicht zwischen 4,20 und 4,60 Meter hoch, in der Breite jeweils 3 Meter. Denn hier handelt es sich um, ein in Kreuzform aufgestelltes, Gerüst.

Die Projektionen aus Linien, die mit 3 D Brille auf der Nase, als Säulen entschlüsselt werden, zitieren die Dominnenarchitektur. Sie bewegen sich ununterbrochen, entstehen, zerfallen, bleiben einen Moment und schon geht eine weitere Bewegung los. Sie werden zu einer stilisierten Gewölbestruktur mit klar erkennbarem Schlussstein als Rosette. Türkis, Rot und Weiß, mehr Farben braucht es nicht. Wenn diese Art der Entstehung vollendet ist, werden Ikonographen auf dem Meshgewebe verteilt: Buttons betitelt mit Activate, drüber Kleine in Wireframe abgebildete Quader, die wie Container aussehen, darin Elemente. Manche sehen aus wie eine Gruppe von x, andere ein einzelnes in x Form dargestelltes Ding, dann wieder nur eine Schiene des x oder aber eine Säulenform. Es sind die Bestandteile des Großen. Die Kästen um diese Miniaturzeichen verschwinden und fliegen frei über das Gewebe, als suchten sie einen geeigneten Ort. Daraus werden eine Anzahl von kreisförmigen Zeichen. Sie sind abstrakt, aber jedes einzelne ist ein Teil eines Großen, es ist eine Gattung, ein Kreis mit Winkel und kleinem Kreis, einer mit Parallele und einem Kreis, einer mit Durchmesseranzeige, andere im Aussehen wie Packmanfresser. Daraus werden große Flächen, bewegte Ausschnitte von etwas anderem. Ein steter Fluss von Klein zu Groß, vom Detail zum Überblick.

Die Projektionen werden durch Geräusche begleitet. Vogelstimmen und entferntes Rauschen. Es kann Wind sein, es kann Meeresrauschen sein. Hört der Besucher auf eine Küste auflaufende Wellen? Ist der Wind vielleicht auch das Geräusch von Wandten? Es ist ein sphärische Musikkulisse. Sie lässt die Vorstellung wandern, vermengt sich mit den Projektionen.

Kleine Bauteile im Schwarm mit Meer und Wind begleitet werden zu Streben, die im Zentrum zum Architektur der Kathedrale werden. Es löst sich auf und beginnt von Neuem. Ein steter Fluss aus Entstehen und Zerfallen.

Es ist kontemplativ, über lange Zeiträume betrachten die Besucher die Projektion.

Uwe Rieger (DE/NZ) mit Yinan Liu (NZ). Stereoprojektionstechnik auf transparente Leinwände. Unterstützt durch das arc/sec Lab for Digital Spatial Orperation an der School of Architecture and Planning der Uiversity of Auckland. Das Interface wurde in Zusammenarbeit mit dem Augmented Human Lab am Bio Engineering Institute entwickelt, das durch Assoc. Prof. Suranga Nanayakkara geleitet wird. As AHLab konzentriert sich auf Human-Computer Interfaces als natürliche Erweiterungen unseres Körpers, Geistes und Verhaltens.

Gesehen auf der Ars Electronia 2018 im Mariendom

Beitrag von Prof. Ursula Drees

ein Beitrag von Xaver Werhahn

Technischer Fortschritt im Bereich Computerleistung und Hardware steht kurz davor, eine Zeitenwende im Alltag der Gesellschaft einzuleiten. Es werden Möglichkeiten erdacht, Menschen von Notwendigkeiten zu befreien, den Komfort zu steigern und die Sicherheit zu verbessern. Dabei handelt es sich teilweise um mondäne Dinge, aber auch um gesellschaftlich brisante wie selbstfahrende Autos oder autonome Kriegsroboter. Die immer weiter fortschreitenden Entwicklungen von neuen und besseren Technologien besitzen das Potenzial das Leben einzelner Individuen aber auch Gesellschaften der Welt maßgeblich zu verändern. Dieses Potenzial kann, soll verwirklicht werden, aber über die Art und Weise besteht keine Einigkeit, da Lebensbereiche betroffen sind, die bisher notwendigerweise ausschließlich von Menschen geregelt wurden. Werden nur in diese Bereiche Roboter eingeführt, erhalten sie Kompetenzen, die die Maschine potenziell über Leben und Tod der Menschen entscheiden lassen, deren Leben sie verbessern sollen. Die Frage, wie diese Kompetenzen ausgestaltet werden könnten, soll in diesem Essay näher erörtert werden. Konkret geht es darum, wie der Umgang selbstfahrender Autos mit Dilemma-Situationen geregelt werden soll. Wenn die Entscheidungshoheit von Mensch auf Maschine übergehen soll, brauchen die Maschinen klare Verhaltensregeln, um das Wohl der Menschen auch in solchen Situationen zu gewährleisten. Mit der Aufstellung von dieser Art von Verhaltensregeln beschäftigen sich derzeit viele verschiedene Ethiker*innen. Drei Positionen haben sich dabei bisher durchgesetzt:

- Konsequentialistisch (Nutzen- bzw. Kostenhierarchie)

- Deontologisch (Pflichten / Verbote)

- Hybrid (Pflichten / Verbote, die bei Bedarf durch Kostenhierarchie ersetzt werden können)

- Deontologisch (Pflichten / Verbote)

Die Konsequentialistische Position schreibt Zuständen Kosten zu und versucht, allgemein gesprochen, die Kosten so gering wie möglich zu halten. Ob in Dilemma Situationen die Priorität auf dem Wohl der Fahrerin oder dem der übrigen Verkehrsteilnehmer*innen liegt, ist abhängig von der konkreten Ausgestaltung (J. Christian Gerdes, Sarah M. Thornton 2015: 91-92). Im Gegensatz dazu schlägt die deontologische Position vor, gewisse Regeln einzuführen, die immer gelten wie z.B.: „the vehicle should avoid collisions regardless of how abrupt the required steering might be“ (J. Christian Gerdes, Sarah M. Thornton 2015: 94). Die dritte Position ist eine Kombination aus den beiden Vorherigen. In Situationen in denen es keine andere Wahl gibt, als gegen eine der immer geltenden Regeln zu verstoßen bietet die Hybrid-Position die Möglichkeit, die Regel durch Kosten zu ersetzen (J. Christian Gerdes, Sarah M. Thornton 2015: 95). Das würde bei der oben genannten Regel zur Folge haben, dass eine Kollision nicht mehr unter allen Umständen vermieden wird, sondern dass der Kollision eine gewisse Menge an Kosten zugeteilt wird, die vermieden werden sollte. Das Problem, dem sich die verschiedenen Positionen stellen, ist, dass in Dilemma Situationen eine Entscheidung für das Wohl der Fahrerin oder für das Allgemeinwohl getroffen werden muss. Diese Entscheidung könnte in Zukunft von den selbstfahrenden Autos getroffen werden. Ich werde in diesem Aufsatz die These vertreten, dass der Entzug der Handlungsmöglichkeit für Menschen in Dilemma Situationen eine Verletzung der Menschenwürde darstellt. Das bedeutet, dass die Implementierung einer der drei genannten Positionen in selbstfahrende Autos weiterhin vorgenommen werden kann, aber dass es dabei für den Menschen immer die Möglichkeit geben muss, selber wieder die Kontrolle über das Fahrzeug an sich zu nehmen. Für die Erörterung meiner These werde ich mich hauptsächlich an dem Buch „Autonomes Fahren : technische, rechtliche und gesellschaftliche Aspekte“ und dem Bericht der Ethikkommission „Automatisiertes und vernetztes Fahren“ aus dem Jahr 2017 orientieren. Während das erste Werk sich der Thematik eher von einem theoretischen Standpunkt nähert, wird im Zweiten mehr Wert auf die rechtlichen Aspekte von selbstfahrenden Autos und den damit einhergehenden Konsequenzen (wie z.B. Datensammlung) gelegt. Im weiteren Vorgehen wird erst ein Blick auf die derzeitige Lage geworfen. Darauf folgt eine knappe Erläuterung der oben bereits erwähnten ethischen Positionen. Weiterhin werden mehrere Dilemma Situationen miteinander verglichen und Bezug auf das Urteil des Bundesverfassungsgerichts zum Luftsicherheitsgesetz genommen. So soll die These, dass der Entzug der Handlungsmöglichkeit für Menschen in Dilemma Situationen eine Verletzung der Menschenwürde darstellt, dann zum Ende der Argumentation eine, wie ich hoffe, zufriedenstellende Begründung erhalten.

Die kurz bevorstehende Zeitenwende ist bereits erwähnt worden. Auf einmal gelangen Möglichkeiten in Reichweite, die bis vor kurzem noch für Science-Fiction galten. Die teilweise vorherrschende Euphorie über diese Entwicklung und den Fortschritt den sie verspricht, wird allerdings durch die Belange unserer Lebensrealität getrübt. Die Tatsache, dass manche Autos mittlerweile ohne menschliche Eingriffe von Punkt A zu Punkt B zu gelangen können, reicht noch lange nicht aus, um solche Autos in Massenproduktion an die Leute zu bringen. Das liegt daran, dass die Fahrzeuge sich nicht in Isolation, sondern in einer von Menschen bevölkerten Umgebung befinden. Damit Autos in so einer Umgebung nicht einen Unfall nach dem anderen auslösen, müssen sie z.B. mit den örtlich vorherrschenden Verkehrsregeln vertraut sein. Sie müssen in der Lage sein, Gefahr einzuschätzen und entsprechend zu reagieren. Für all das wird eine sehr große Menge an Daten benötigt, die live aufgenommen und verarbeitet werden müssen. Das bedeutet, dass die jeweils aktuelle Umgebung des Autos konstant aufgenommen und verarbeitet wird. Selbst das kann aber noch nicht ausreichend sein, um dem Auto genügend Daten zur Verfügung zu stellen, wenn ein Unfall direkt bevorsteht. Da würde ein vernetztes System aushelfen, wo alle verfügbaren Autodaten gesammelt und geteilt werden, um so auch in sekundenbruchteilen die möglichen Unfallfolgen vorherzusehen. Die Sammlung von Daten der Fahrer*innen ist bereits äußerst sensibel. Es ließen sich auf diese Weise präzise Bewegungsprofile erstellen. Wird dies noch kombiniert mit einer konstanten Aufnahme und Verarbeitung der Umgebung, rückt der Albtraum des totalitären Überwachungsstaats, der alles sieht und kontrolliert, gefährlich nah. „Ob in Zukunft eine dem Bahn- und Luftverkehr entsprechende vollständige Vernetzung und zentrale Steuerung sämtlicher Kraftfahrzeuge im Kontext einer digitalen Verkehrsinfrastruktur möglich und sinnvoll sein wird, lässt sich heute nicht abschätzen. Eine vollständige Vernetzung und zentrale Steuerung sämtlicher Fahrzeuge im Kontext einer digitalen Verkehrsinfrastruktur ist ethisch bedenklich, wenn und soweit sie Risiken einer totalen Überwachung der Verkehrsteilnehmer und der Manipulation der Fahrzeugsteuerung nicht sicher auszuschließen vermag“ (Ethikkommission Bericht Juni 2017).

Mit diesen und anderen Problemen der Implementierung solch neuer Technologien beschäftigt sich die Ethikkommission. Beim Thema Daten empfiehlt sie: „Erlaubte Geschäftsmodelle, die sich die durch automatisiertes und vernetztes Fahren entstehenden, für die Fahrzeugsteuerung erheblichen oder unerheblichen Daten zunutze machen, finden ihre Grenze in der Autonomie und Datenhoheit der Verkehrsteilnehmer“ (Ethikkommission Bericht Juni 2017). Sollten all die Probleme, die mit der Implementierung zusammenhängen, tatsächlich zufriedenstellend gelöst werden, ist allerdings der Umgang mit Dilemma Situationen weiterhin ein, wenn nicht sogar der, ausschlaggebender Faktor. Hier spricht die Ethikkommission dem Schutz des menschlichen Lebens zwar die höchste Priorität zu, aber gleichzeitig gibt sie zu, dass „Echte dilemmatische Entscheidungen […] nicht eindeutig normierbar und auch nicht ethisch zweifelsfrei programmierbar“ sind (Ethikkommission Bericht Juni 2017).

Als Beispiel für so ein Dilemma soll folgende Situation gelten: man selbst befindet sich in einem selbstfahrenden Auto und es gibt keine andere Möglichkeit als entweder eine Gruppe von Kindern zu überfahren oder den Kindern auszuweichen und dann selber mitsamt Auto von einer Klippe in den Tod zu stürzen. Es lassen sich aber auch Situationen erdenken, in denen nicht direkt das Leben anderer auf dem Spiel steht. Angenommen man selbst befindet sich in einem selbstfahrenden Auto, das sich entscheiden muss von einer Klippe zu fahren oder einen Tanklaster von der Straße zu drängen. Der Tanklaster würde nun das lokale Kraftwerk in Brand setzen und so für einen weitreichenden Stromausfall sorgen, der z.B. in Krankenhäusern etliche Tode zur Folge hätte. Das Problem das all diesen Dilemma Situationen gemein ist, ist der Konflikt zwischen dem individuellen Wohl der einzelnen Person und dem Allgemeinwohl der Gesellschaft.

Die bereits kurz angerissenen ethischen Positionen würden hier zu unterschiedlichen Ergebnissen führen. Die konsequentialistische Position teilt allen Objekten der Umgebung Kosten zu. Je höher die Kosten eines Objekts, desto wichtiger ist dieses Objekt. Je nachdem, wie die Kostenfunktion gestaltet wird, erhält das Auto der fahrenden Person höhere Kosten als die Umgebung oder geringere. An diesen Kosten orientiert sich das Auto und folgt dem Pfad, der laut Berechnung die geringsten Kosten verursacht. Vermutlich würde die Programmierung des Fahrzeugs dem Wohl der Fahrerin höhere Kosten als der Umgebung zurechnen, so dass die Fahrerin im Zweifel überlebt. Die deontologische Position erhebt wiederum Regeln, die absoluten Geltungsanspruch haben, wie z.B. „es soll unter allen Umständen eine Kollision vermieden werden“. Diese Position würde dazu führen, dass das Auto mitsamt der Fahrerin von der Klippe fahren würde, ohne dass die Fahrerin die Möglichkeit hätte Einfluss auf diesen Prozess zu nehmen. Da dies zwar als gesellschaftlich wünschenswert gelten mag, aber möglicherweise nicht durchsetzungsfähig ist, hat sich noch eine dritte Position entwickelt, die die deontologische mit der konsequentialistischen Position zu kombinieren sucht. Diese dritte „Hybrid“-Position ist dafür gedacht, dass in Fällen, in denen die deontologische Verhaltensweise das Fahrzeug handlungsunfähig macht, wieder Handlungsspielraum erschlossen wird indem die Regel durch besonders hohe Kosten ersetzt wird. Die Regel kann das Fahrzeug nicht brechen, aber die Kosten kann es theoretisch in Kauf nehmen, wenn keine bessere Alternative erscheint (J. Christian Gerdes, Sarah M. Thornton 2015: 95). In allen Fällen liegt jedoch die letzte Entscheidung über das Leben der Fahrerin und der Kinder noch beim Auto bzw. in der Programmierung.

Man könnte meinen, dass die Gesetzgeber hier gar keine richtige Entscheidung finden könnten, allerdings wurde vor gut zehn Jahren ein Urteil vom Bundesverfassungsgericht getroffen, das auch in diesem Fall in gewisser Hinsicht richtungsweisend sein kann. Damals ging es um die Frage, ob Abschüsse von Verkehrsflugzeugen mit dem Gesetz vereinbar wären. Auch hier handelt es sich also um eine Abwägung zwischen dem Wohl der Einzelnen (Flugzeuginsassen) und dem Allgemeinwohl (direkte oder indirekte Todesopfer). Das Bundesverfassungsgericht beschloss, dass „die Abschussermächtigung gegen das Grundrecht auf Leben (Art. 2 Abs. 2 Satz 1 GG) und die Garantie der Menschenwürde (Art. 1 Abs. 1 GG) [verstoße]“ (Website Bundesverfassungsgericht).

Dies unterstreicht erneut die aufgestellte These, dass der Entzug der Handlungsmöglichkeiten der Fahrer*innen eines Autos eine Verletzung der Menschenwürde darstellt. Zwar kommt es in den Dilemma Situationen, auf die im Zusammenhang mit selbstfahrenden Fahrzeugen Bezug genommen wurde, nicht zu einem Gewaltakt oder einem gezielten Angriff auf die Gesellschaft. Es kommt aber zu einer Objektivierung der Fahrer*innen von Personen zum Objekt gesellschaftlichen Handelns. Wert und Erhalt ihrer Leben wäre dann nicht mehr ein Zweck in sich, sondern würden in die „Hände“ des Autos gelegt, das sie als bloße Objekte einer Rechnung betrachtet. Auch die Ethikkommission kommt zu einer ähnlichen Einschätzung in Bezug auf die Entscheidungshoheit in Dilemma Situationen: „Letztendlich würde also im Extremfall der Programmierer oder die Maschine die „richtigen“ ethischen Entscheidungen über das Ableben des einzelnen Menschen treffen können. Konsequent weitergedacht, wäre der Mensch in existentiellen Lebenssituationen nicht mehr selbst-, sondern vielmehr fremdbestimmt. Diese Konsequenz ist in vielerlei Hinsicht problematisch. Einerseits besteht hier die Gefahr eines starken Paternalismus des Staates, bei dem eine „richtige“ ethische Handlungsweise vorgegeben wird (sofern dieser die Programmierung vorgibt), andererseits würde dies dem Wertebild des Humanismus, in dem das Individuum im Zentrum der Betrachtungsweise steht, widersprechen. Eine solche Entwicklung ist daher kritisch zu betrachten“ (Bericht 2017). Ich sehe damit die unbedingte Notwendigkeit die Entscheidungshoheit in jedem Fall beim Menschen zu lassen als hinreichend begründet an. Egal wie düster die Konsequenzen für eine Gesellschaft auch sein mögen, niemand ist verpflichtet ihr oder sein eigenes Leben dafür zu opfern. Dieses Opfer in Form von Programmierung zu erzwingen entspricht einer tiefen Verletzung der Menschenwürde und ist unter allen Umständen zu verhindern. Das bedeutet aber nicht, dass deswegen keine selbstfahrenden Autos in die Gesellschaft eingeführt werden dürften. Nur soll, dem Grundgedanken einer Demokratie entsprechend, jede*r ihre oder seine eigenen Belange selber regeln können.

Wäre ich in der Situation den Gesetzgebern eine Handlungsempfehlung bezüglich Selbstfahrender Fahrzeuge in Dilemma Situationen zu geben, so würde ich auf der Möglichkeit bestehen, selber die Kontrolle über das Fahrzeug übernehmen zu können. Es handelt sich um eine technologische Möglichkeit, die auf eine nicht ausreichend vorbereitete Lebenswelt trifft. Eine Implementierung dieser technischen Möglichkeiten wird aber vermutlich trotzdem erfolgen. Das darf aber nicht dazu führen, dass der einzelne Mensch im Konfliktfall dem Allgemeinwohl untergeordnet wird. Auch die Ethikkommission sowie das Bundesverfassungsgericht kommen zu diesem Schluss. Die erwähnten ethischen Positionen bilden eine gute Grundlage für die Implementierung von Richtlinien in selbstfahrende Fahrzeuge, aber nur solange der Mensch in jedem Fall die Entscheidungshoheit behält.

Literaturverzeichnis:

- Bericht Ethikkommission Juni 2017: „Automatisiertes und vernetztes Fahren“

- J. Christian Gerdes, Sarah M. Thornton 2015: „Autonomes Fahren : technische, rechtliche und gesellschaftliche Aspekte“

Zum Referenten:

Xaver Werhahn, geboren 1989 in Bremen, studiert Philosophie, Politikwissenschaft und Geschichte an der Universität Regensburg. Individualität, Autonomie und fortschreitende Algorithmisierung der Lebenswelten stehen im Fokus seiner Forschung.

ein Essay von Xaver Werhahn

Roboter üben schon lange eine große Faszination auf die Menschen aus. Seit geraumer Zeit machen sich Menschen Gedanken über die Chancen und Risiken, die einher gehen mit der Thematik der Roboter. Ob in düster gemalten Dystopien der Zukunft, Universitäten, großen Wirtschaftsunternehmen oder direkt im eigenen Heim: überall halten Roboter Einzug in die Lebenswelt der Menschen und beeinflussen diese maßgeblich. Der Reichweite der Einsatzbereiche von Robotern scheint keine Grenze gesetzt zu sein. Es scheint als wenn sie viele Aufgaben, die von Menschen verrichtet werden, besser erledigen könnten. Wenn wir davon ausgehen müssen, dass sich in den nächsten Jahrzehnten Roboter immer weiterverbreiten werden, erscheinen die dystopischen Zukunftsversionen in denen Menschen von Maschinen als Sklaven gehalten oder nahezu ausgerottet werden auf einmal sehr viel drängender. Aber was ist wirklich dran an diesen Vorstellungen? Sind Roboter kurz davor sich die Menschheit untertan zu machen? Im Moment beschränken sich solche Szenarien noch auf Science-Fiction und das wird vermutlich auch noch für gewisse Zeit so bleiben. Dennoch werden Roboter immer raffinierter und vielseitiger einsetzbar. Wenn die U-Bahn in London oder Tokio fährt, sitzt kein Mensch mehr am Steuer. Das gleiche geschieht, wenn im Flugzeug der Autopilot eingeschaltet wird. Bald werden vermutlich sogar unsere Autos nicht mehr von uns gesteuert werden müssen, sondern sie fahren von alleine.

Nun drängt sich die Frage nach der Kontrolle bzw. der Verantwortlichkeit auf. Denn was passiert, wenn sich ein selbstfahrendes Auto entscheiden müsste zwischen dem Tod seiner Insassen und dem Tod von Unbeteiligten? Befürworter der Eigenständigkeit von Robotern halten ihre Wahrnehmungsfähigkeit und die Fähigkeit mit ihrer Umwelt in Interaktion zu treten für ausreichend, um Roboter in der Kategorie der intelligenten Wesen einzuordnen (Keil 1998: 108-109). Das hätte zur Folge, dass Roboter durchaus zur Verantwortung gezogen werden könnten für ihre Taten. Gegner dieser Position bestreiten, dass ein Roboter freie Entscheidungen treffen kann. Dafür wäre Willensfreiheit nötig, aber alle „Faktoren, die es […] unmöglich machen, begründet seinen Willen zu bilden, tangieren die Willensfreiheit“ _und davon gäbe es beim Roboter genug (Keil 2013: 5). Auch diese Position wird in Frage gestellt, da manche behaupten, dass die Willensfreiheit nicht der ausschlaggebende Faktor sei. Es gehe vielmehr darum, wie autonom und ethisch sensibel ein Roboter ist. Bei voller Ausprägung dieser beiden Eigenschaften, werden Roboter als „trustworthy moral agents“ _bezeichnet (Colin Allen, Wendell Wallach 2010: 26). Die Frage ist also, ob Roboter in der Lage sind moralisch zu handeln oder nicht. Ich werde die Position vertreten, dass Roboter nicht moralisch handeln können, da sie nichts weiter als besonders vielseitige Maschinen sind und insofern gar keine Handlung vorliegt. Um dies darzulegen versuche ich über die Begriffe von Verantwortung und Absicht zu zeigen, dass die Selbstständigkeit und die Möglichkeit aus einer Reihe von Alternativen zu wählen uns an die Illusion eines autonomen Akteurs glauben lassen, der eigenständige Entscheidungen fällen kann. Das ist allerdings ein Trugschluss, denn Roboter treffen keine Entscheidungen, sondern führen lediglich die Entscheidungen aus, die Menschen bei ihrer Konstruktion getroffen haben.

Roboter entscheiden sich nicht dafür Autos zusammen zu setzen, sondern sie werden von Menschen so konstruiert und programmiert, dass sie genau das tun. Anhänger Frankfurts könnten hier einwenden, dass, nur weil sie keine Alternative haben, sie nicht trotzdem genau das tun wollen. Genau da liegt der Knackpunkt, denn Roboter wollen nicht. Genauso wenig wie der Toaster toasten, der Mixer mixen und der Taschenrechner rechnen will, will ein Roboter Autos zusammensetzen. Beim Toaster, Mixer und Taschenrechner würden die meisten mir vermutlich zustimmen. Beim Roboter würden mir aber vermutlich auch einige widersprechen. Woran liegt das? Wo liegt der Unterschied zwischen Roboter und Toaster? Weder der Toaster noch der Roboter können sich fortpflanzen. Weder der 2 Toaster noch der Roboter können eine andere Aufgabe erfüllen als die für die sie gebaut wurden. Weder Toaster noch Roboter können sich entscheiden welche Aufgabe sie erfüllen und welche nicht.

Wir schreiben dem Toaster keine böse Absicht zu, wenn das Toast verbrennt, weil der Mensch für die Hitzeeinstellung selber verantwortlich ist. Schreiben wir dem Roboter böse Absicht zu, wenn er wie vorgesehen funktioniert und dabei jemand zu Schaden kommt? Dem Saubermach-Roboter schreiben wir wohl keine böse Absicht zu, wenn er uns beim Gehen aus dem Gleichgewicht bringt, weil er genau in dem Moment seine Putzroutine durchführt. Was wäre, wenn der Saubermach-Roboter nun Sensoren und Programmierung besitzt, die ihn solche Situationen erkennen und vermeiden lassen? Was wäre, wenn der Saubermach-Roboter trotzdem dem Menschen in die Quere kommt und ihn zu Fall bringt? Nun scheint der Fall anders zu sein als zuvor. Der Roboter hat die Vorgabe dem Menschen nicht in die Quere zu kommen und dennoch passierte genau das. Ist die Ursache dafür die Entscheidung des Roboters, seine Vorgaben zu missachten, oder liegt einfach ein Fehler im System der Maschine vor? Auch hier würden mir vermutlich die meisten zustimmen, wenn ich sage, dass ein Fehler im System die wahrscheinlichere von den zwei genannten Optionen ist.

Aber was ist, wenn dem Roboter vorgegeben wird, niemals seiner Umgebung zu schaden? Eines Tages kommt es zufällig zu einer Situation in der sich so viele Personen in direkter Nähe des Saubermach-Roboters aufhalten, die ihn nicht beachten und gleichzeitig alle dem Roboter in den Weg treten, dass dem Roboter nichts übrigbleibt als einer Person zu schaden. Diese Person landet mit einem gebrochenen Bein im Krankenhaus und verlangt nun eine Entschädigung. Ich bin mir sicher, dass auch in diesem Fall keine vernünftige Person auf die Idee kommen würde, ernsthaft den Roboter für die Geschehnisse verantwortlich zu machen. Denn es handelt sich um eine simple Ursache-Wirkung Beziehung. Die Ursache, dass der Roboter auf dem Boden in Bewegung war, hat bewirkt, dass ein Mensch zu Schaden kam.

Wären Ursache und Wirkung die ausschlaggebenden Kriterien für eine Handlung hätten wir allerdings ein Problem. Denn dann wären auf einmal das Umkreisen der Sonne oder das Fallen von Tropfen allesamt Handlungen. Das ist per se noch nicht unlogisch, würde aber die Begriffe Handlung und Verantwortung entwerten bzw. ad absurdum führen, da nun alles was passiert eine Handlung wäre. Nicht mehr die Person, die unachtsam eine glimmende Zigarette auf den Boden wirft wäre für das entstehende Feuer verantwortlich, sondern die Zigarette selber oder aber die allererste Ursache, die es gab. Würde ich nun fragen, wer oder was gehandelt hat, würde ich schlussendlich bis zum Urknall kommen und ab dann warten müssen, dass im Bereich der Physik deutliche Fortschritte gemacht werden.

Eine Handlung scheint also nicht durch Ursache und Wirkung definiert zu sein, sondern durch die Absicht. Die Erde hat keine Absicht, wenn sie sich um die Sonne dreht. Der Wassertropfen hat keine Absicht, wenn er zu Boden fällt. Der Toaster hat keine Absicht, wenn er Weißbrot kross macht. Warum schreiben wir dann dem Roboter eine Absicht zu? Ich denke es liegt daran, dass der Eindruck entsteht, Roboter würden Entscheidungen treffen. Allerdings trifft nicht der Roboter die Entscheidungen, sondern die Menschen, die ihn konstruiert haben trafen die Entscheidungen im Voraus. Würde allein die Möglichkeit zwischen verschiedenen Alternativen zu wählen, ohne dass jemand während des „Wahlmoments“ _Einfluss auf diesen Prozess nimmt, schon eine hinreichende Bedingung für autonomes Handeln sein – _und damit aus einer Maschine einen Akteur machen – _könnte ich jederzeit einen „Killerroboter“ auf die Menschen loslassen und wäre nicht verantwortlich.

Die vom Menschen scheinbar unabhängige Funktionstüchtigkeit sowie die Möglichkeit aus verschiedenen Alternativen zu wählen suggerieren die Existenz eines autonomen Akteurs, der selber Entscheidungen treffen kann, wie es ihm beliebt. Das führt dazu, dass dem Roboter auf einmal Absicht und (moralische) Handlungsfähigkeit zugerechnet wird, obwohl nichts anderes passiert als bei einem 3

Thermostat, das auf die Umgebungstemperatur reagiert. Ich denke die Wenigsten würden einem Thermostat, das die Temperatur ihrem Sollwert angleicht, irgendeine Absicht unterstellen. Zumindest halte ich es für sehr unwahrscheinlich, dass ein vernunftbegabter Mensch das Thermostat dafür zur Verantwortung ziehen würde, seinem Zweck zu entsprechen.

Roboter sind weiterhin Maschinen, die ihrer Konstruktion entsprechend funktionieren und keine Absichten irgendeiner Art besitzen. Damit sind Roboter nicht in der Lage irgendwelche Handlungen geschweige denn moralische Handlungen auszuführen.

Die Thematik von Robotern ist mittlerweile in so vielen Bereichen der Lebenswelt angekommen, dass selbst der Laie davon gehört bzw. selber Zugang dazu hat. Roboter nehmen schon heute maßgeblichen Einfluss auf das Leben vieler Menschen. Teilweise hat das eine positive Konnotation, wenn man darüber nachdenkt, dass Menschen nun weniger schwere Arbeiten verrichten müssen. Teilweise hat es aber auch eine deutlich negative Konnotation, weil viele Menschen ihre Arbeit verlieren und möglicherweise sogar ruiniert werden. Dieser Prozess wird sich vermutlich trotzdem weiter fortsetzen, da die Möglichkeiten und Annehmlichkeiten, die den Menschen dadurch entstehen zu verlockend sind. Deswegen sollte in diesem Essay der Frage nachgegangen werden, ob Roboter moralisch handeln können. Denn wenn die Menschen immer mehr und immer wichtigere Bereiche ihres Lebens in die Hände von Robotern geben, scheint es wünschenswert, dass die Roboter auch achtsam damit umgehen.

Ich habe auf den letzten Seiten die Meinung vertreten, dass wir Roboter nicht verantwortlich machen können, da sie keine autonomen Akteure, sondern Maschinen sind. Begründet habe ich diese Position damit, dass Menschen fälschlicherweise Roboter personifizieren, weil sie scheinbar frei Entscheidungen treffen. Die scheinbare Möglichkeit Entscheidungen zu treffen in Kombination mit der scheinbaren Selbstständigkeit verleiten zu dem Fehlschluss, dass Roboter autonome Akteure mit Handlungsfähigkeit wären. Handlungen sind aber mehr als eine Beziehung zwischen Ursache und Wirkung sondern erfordern Absicht. Allein die Auswahlmöglichkeit aus verschiedenen Alternativen macht keine absichtliche Entscheidung aus, sondern stellt lediglich den Einsatzbereich dar, den die Konstrukteure der Maschine einräumen. Deswegen sind Roboter nicht in der Lage moralisch zu handeln, da sie keine handlungsfähigen Akteure sind.

Literaturverzeichnis:

-Geert Keil „Was Roboter nicht können“ in: Der Mensch in der Perspektive der Kognitionswissenschaften, Kognitionswissenschaften, Frankfurt am Main 1998.

– Geert Keil: „Willensfreiheit“, Berlin 2013.

– Wendell Wallach, Colin Allen: „Moral Machines“, Oxford 2010.

Zum Referenten:

Xaver Werhahn, geboren 1989 in Bremen, studiert Philosophie, Politikwissenschaft und Geschichte an der Universität Regensburg. Individualität, Autonomie und fortschreitende Algorithmisierung der Lebenswelten stehen im Fokus seiner Forschung.